GPars 框架 - 参考文档

作者:GPars 全员

版本 1.2.1

目录

1 简介

当今主流计算世界正在快速变化。如果您打开计算机的引擎盖,看看里面的东西,您很有可能看到一个双核处理器。或者,如果您有一台高端电脑,则可能看到一个四核处理器。我们现在都将软件运行在多处理器系统上。我们今天和明天编写的代码可能永远不会在单处理器系统上运行:并行硬件已成为标准。但软件却没有,至少现在还没有。人们仍然创建单线程代码,即使它无法利用当前和未来硬件的全部能力。一些开发人员尝试使用低级并发原语,例如线程、锁或同步块。但是,很明显,在应用程序级别使用的共享内存多线程方法带来的麻烦比它解决的麻烦还要多。低级并发处理通常很难做对,而且也不太有趣。随着硬件的这种根本性变化,软件不可避免地也必须发生巨大变化。像 map/reduce、fork/join、actor 和数据流这样更高级的并发和并行概念,为不同的问题域提供了自然的抽象,同时利用了多核硬件。1.1 GPars 简介

认识一下 GPars - 一个针对 Java 和 Groovy 的开源并发和并行库,它为您提供了许多编写 Groovy 并发和并行代码的高级抽象(map/reduce、fork/join、异步闭包、actor、agent、数据流并发和其他概念),可以轻松地使您的 Java 和 Groovy 代码并发和/或并行。使用 GPars,您的 Java 和/或 Groovy 代码可以轻松地利用目标系统上的所有可用处理器。您可以同时运行多个计算、并行请求网络资源、安全地解决分层分治问题、执行函数式风格的 map/reduce 或数据并行集合处理,或者以 Actor 或数据流模型为基础构建应用程序。该项目在 Apache 2 许可证 下开源。如果您正在使用 Groovy 开发商业、开源、教育或任何其他类型的软件项目,请下载二进制文件或从 Maven 存储库中集成它们,然后开始吧。编写高度并发和/或并行 Java 和 Groovy 代码的方式是畅通无阻的。尽情享受吧!

1.2 致谢

如果没有许多个人提供的巨大帮助和贡献,该项目不可能达到目前的水平,他们贡献了时间、精力和专业知识,使 GPars 成为一款可靠的产品。首先,应该提到的就是核心团队的人员- Václav Pech

- Dierk Koenig

- Alex Tkachman

- Russel Winder

- Paul King

- Jon Kerridge

随着时间的推移,许多人贡献了他们的想法,提供了有用的反馈,或以某种方式帮助了 GPars。这个群体中有很多很多人,太多以至于无法一一列出,但至少让我们列出最活跃的人

- Hamlet d'Arcy

- Hans Dockter

- Guillaume Laforge

- Robert Fischer

- Johannes Link

- Graeme Rocher

- Alex Miller

- Jeff Gortatowsky

- Jiří Kropáček

衷心感谢所有人!

2 入门

在我们开始之前,让我们先做一些假设- 您了解并使用 Groovy 和 Java:否则,您就不会花宝贵的时间研究针对 Groovy 和 Java 的并发和并行库。

- 您绝对希望使用 Groovy 和 Java 编写利用并发和并行的代码。

- 如果您不使用 Groovy 编写代码,那么您准备为使用 Java 支付不可避免的冗长性税。

- 您的代码针对的是多核硬件。

- 您理解在并发和并行代码中,事情可能在任何时间、以任何顺序发生,而且很可能不止一件事同时发生。

有了这些假设,我们就开始吧。

越来越明显的是,使用 JVM 提供的线程/同步/锁级别来处理并发和并行,对于安全性和舒适性来说,级别太低了。许多高级概念,例如 actor 和数据流,已经存在了一段时间:并行计算机至少在数据中心(如果不是在桌面)上已经使用,早于多核芯片进入硬件主流。现在是时候在主流软件行业中采用这些更高级的抽象了。这就是 GPars 为 Groovy 和 Java 语言提供的功能,它允许 Groovy 和 Java 程序员使用更高级的抽象,从而使开发并发和并行软件变得更容易,错误更少。

在 GPars 中可用的概念可以分为三组

- 代码级别帮助程序 可以应用于代码库的较小部分(例如单个算法或数据结构)的构造,而无需对整个项目架构进行任何重大更改

- 并行集合

- 异步处理

- Fork/Join(分治)

- 架构级别概念 在设计项目结构时需要考虑的构造

- Actor

- 通信顺序进程 (CSP)

- 数据流

- 数据并行

- 共享可变状态保护 尽管目前约 95% 的共享可变状态的使用可以通过使用适当的抽象来避免,但对于剩余的 5% 的用例来说,好的抽象仍然是必要的,因为在这种情况下无法避免共享可变状态

- Agent

- 软件事务内存(GPars 尚未完全实现)

2.1 下载和安装

GPars 现在与 Groovy 一起作为标准发行。因此,如果您有 Groovy 安装,则应该已经拥有 GPars。当然,您拥有的 GPars 的确切版本将取决于 Groovy 的版本。如果您还没有 GPars,但您确实有 Groovy,那么也许您应该升级您的 Groovy!如果您没有 Groovy 安装,但通过使用依赖项或仅仅拥有 groovy-all 工件来获取 Groovy,那么您将需要获取 GPars。另外,如果您想要使用与 Groovy 一起提供的 GPars 版本不同的版本,或者拥有一个无法升级的旧的没有 GPars 的 Groovy,那么您将需要获取 GPars。获取 GPars 的方法有

- 从存储库中下载工件,并手动添加它以及所有传递依赖项。

- 在 Gradle、Maven 或 Ivy(或 Gant 或 Ant)构建文件中指定依赖项。

- 使用 Grapes(对于 Groovy 脚本特别有用)。

如果您正在构建 Grails 或 Griffon 应用程序,可以使用相应的插件来为您获取 jar 文件。

GPars 工件

如上所述,GPars 现在与 Groovy 一起作为标准发行。但是,如果您必须手动管理此依赖项,则 GPars 工件位于主 Maven 存储库以及 Codehaus 主存储库和快照存储库中。发布版本位于 Maven 和 Codehaus 主存储库中,当前开发版本 (SNAPSHOT) 位于 Codehaus 快照存储库中。要从 Gradle 或 Grapes 中使用,请使用以下规范

"org.codehaus.gpars:gpars:1.2.1""org.codehaus.gpars:gpars:1.3-SNAPSHOT"<dependency>

<groupId>org.codehaus.gpars</groupId>

<artifactId>gpars</artifactId>

<version>1.2.0</version>

</dependency>传递依赖项

GPars 作为库依赖于 Groovy 版本等于或大于 2.0。此外,Fork/Join 并发库,即 jsr166y(来自 JSR-166 项目 的一个工件)必须在使用 GPars 的程序的类路径上,才能进行编译和执行。该工件的发布版本位于主 Maven 和 Codehaus 存储库中。该工件的开发版本位于 Codehaus 快照存储库中。使用 Gradle 或 Grapes,您将使用以下依赖项规范

"org.codehaus.jsr166-mirror:jsr166y:1.7.0"<dependency>

<groupId>org.codehaus.jsr166-mirror</groupId>

<artifactId>jsr166y</artifactId>

<version>1.7.0</version>

</dependency>GPars 在其自己的描述符中定义了此依赖项,因此,如果您使用 Gradle、Grails、Griffon、Maven、Ivy 或其他类型的自动依赖项解析工具,理想情况下,所有依赖项管理都应该自动完成。

有关更多详细信息,请访问 GPars 网站上的 集成 页面。

2.2 Hello World 示例

设置完成后,尝试运行以下 Groovy 脚本以测试您的设置是否按预期工作。import static groovyx.gpars.actor.Actors.actor/** * A demo showing two cooperating actors. The decryptor decrypts received messages * and replies them back. The console actor sends a message to decrypt, prints out * the reply and terminates both actors. The main thread waits on both actors to * finish using the join() method to prevent premature exit, since both actors use * the default actor group, which uses a daemon thread pool. * @author Dierk Koenig, Vaclav Pech */

def decryptor = actor { loop { react { message -> if (message instanceof String) reply message.reverse() else stop() } } }

def console = actor { decryptor.send 'lellarap si yvoorG' react { println 'Decrypted message: ' + it decryptor.send false } }

[decryptor, console]*.join()

GPars 主要设计用于与 Groovy 编程语言一起使用。当然,所有 Java 和 Groovy 程序都只是在 JVM 上运行的字节码,因此 GPars 可以与 Java 源代码一起使用。尽管 GPars 针对 Groovy 代码使用,但其坚实的技术基础加上良好的性能特性,使其成为 Java 程序的优秀库。事实上,GPars 的大部分是用 Java 编写的,因此使用 GPars 的 Java 应用程序不会产生任何性能损失。有关详细信息,请参阅 Java API 部分。

要使用 Java API 通过 GPars 进行快速测试,您可以编译并运行以下 Java 代码

import groovyx.gpars.MessagingRunnable; import groovyx.gpars.actor.DynamicDispatchActor;public class StatelessActorDemo { public static void main(String[] args) throws InterruptedException { final MyStatelessActor actor = new MyStatelessActor(); actor.start(); actor.send("Hello"); actor.sendAndWait(10); actor.sendAndContinue(10.0, new MessagingRunnable<String>() { @Override protected void doRun(final String s) { System.out.println("Received a reply " + s); } }); } }

class MyStatelessActor extends DynamicDispatchActor { public void onMessage(final String msg) { System.out.println("Received " + msg); replyIfExists("Thank you"); }

public void onMessage(final Integer msg) { System.out.println("Received a number " + msg); replyIfExists("Thank you"); }

public void onMessage(final Object msg) { System.out.println("Received an object " + msg); replyIfExists("Thank you"); } }

2.3 代码规范

我们在代码示例中遵循某些规范。了解这些规范可能有助于您更好地阅读和理解 GPars 代码示例。- 在 Actor、Agent 和数据流表达式(变量和流)上,左移 运算符 << 已经重载,表示向其 发送 消息或 赋值。

myActor << 'message'myAgent << {account -> account.add('5 USD')}

myDataflowVariable << 120332

- 在演员和代理中,默认的 call() 方法也被重载为 send 。因此,向演员或代理发送消息看起来就像一个普通的函数调用。

myActor "message"myAgent {house -> house.repair()}

- 在 GPars 中,rightShift 运算符 >> 具有 when bound 含义。所以

myDataflowVariable >> {value -> doSomethingWith(value)}在示例中,我们倾向于静态导入常用的工厂方法

- GParsPool.withPool()

- GParsPool.withExistingPool()

- GParsExecutorsPool.withPool()

- GParsExecutorsPool.withExistingPool()

- Actors.actor()

- Actors.reactor()

- Actors.fairReactor()

- Actors.messageHandler()

- Actors.fairMessageHandler()

- Agent.agent()

- Agent.fairAgent()

- Dataflow.task()

- Dataflow.operator()

这更多是一个风格偏好和个人品味的问题,但我们认为静态导入使代码更紧凑易读。

2.4 在 IDE 中进行设置

将 GPars jar 文件添加到您的项目中或在 pom.xml 中定义适当的依赖项,就足以让您在 IDE 中开始使用 GPars。GPars DSL 识别

IntelliJ IDEA,无论是免费的 社区版 还是商业版的 终极版,都将识别 GPars 领域特定语言,完成方法,例如 eachParallel()、reduce() 或 callAsync() 并验证它们。GPars 使用 GroovyDSL 机制,该机制会在 GPars jar 文件添加到项目中时立即将 DSL 教给 IntelliJ IDEA。

2.5 概念的适用性

GPars 提供了许多概念可供选择。我们正在不断构建和更新一个页面,试图帮助用户为其手头的任务选择正确的抽象。有关详细信息,请参阅 概念比较 页面。为了简要总结建议,您可以在下面找到基本指南

- 您正在查看一个集合,需要 迭代 或使用众多优美的 Groovy 集合方法(如 each()、collect()、find() 等)进行处理。假设处理集合的每个元素都独立于其他项目,可以使用 GPars 并行集合 来推荐。

- 如果您有一个 长时间运行的计算,可以安全地在后台运行,请使用 GPars 中的 异步调用支持。由于 GPars 异步函数可以组合,因此您可以快速并行化复杂的函数计算,而无需显式标记独立计算。

- 您需要 并行化 手头的算法。您可以识别一组具有相互依赖关系的 任务。这些任务通常不需要共享数据,但某些任务可能需要等待其他任务完成才能启动。您已准备好以代码明确表达这些依赖关系。使用 GPars 数据流任务,您可以创建内部顺序任务,每个任务都可以与其他任务并发运行。数据流变量和通道为任务提供了表达其依赖关系并安全交换数据的能力。

- 您无法避免在算法中使用 共享可变状态。多个线程将访问共享数据,并(其中一些)修改它。传统的锁定和同步方法感觉太冒险或不熟悉。选择 代理,它将包装您的数据并序列化对它的所有访问。

- 您正在构建一个具有高并发需求的系统。在这里或那里调整数据结构或任务将无法满足需求。您需要从头开始构建体系结构,以考虑并发。消息传递 可能是可行的解决方案。

- Groovy CSP 将为您提供用于并发进程的高度确定性和可组合模型。该模型围绕 计算 或 进程 的概念进行组织,这些计算或进程并发运行并通过同步通道进行通信。

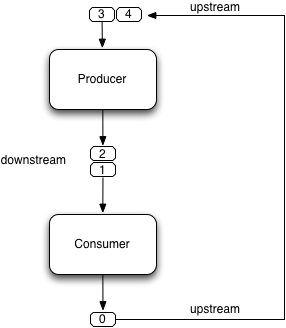

- 如果您正在尝试解决复杂的数据处理问题,请考虑使用 GPars 数据流运算符 来构建数据流网络。该概念围绕使用异步通道连接到管道中的事件驱动变换进行组织。

- 演员 和 活动对象 将在您需要根据面向对象范式构建通用的、高度并发和可扩展的体系结构时大放异彩。

现在,您可能对在当前项目中使用哪些概念有了更好的了解。转到用户指南中查看有关它们的更多详细信息。

2.6 新功能

新的 GPars 1.2.0 版本在先前版本的基础上引入了一些增强功能和改进,主要是在数据流领域。查看 JIRA 发布说明

项目更改

查看 重大更改列表 以了解重大更改的列表。

异步函数

并行集合

Fork / Join

Actor

- 使用 @DelegatesTo 对演员和演员工厂方法进行注释,以允许在静态编译的 Groovy 代码中使用演员

数据流

- 向 Promises 添加了一个 thenForkAndJoin() 方法,以简化使用 promises 创建 fork/join 算法

- 添加了延迟任务,以简化异步活动的创建,其执行将延迟到实际请求其结果时

- 使用 @DelegatesTo 对运算符工厂方法进行注释,以允许在静态编译的 Groovy 代码中使用数据流运算符和选择器

代理

Stm

其他

- 将 java.util.Timer 替换为 ScheduledExecutorService 用于超时处理

- 在 GParsConfig 类中添加了对计时器和线程本地变量的正确关闭

重命名提示

2.7 Java API - 从 Java 中使用 GPars

使用 GPars 非常令人上瘾,我保证。一旦你上瘾,你就无法没有它进行编码。如果世界强迫你用 Java 编写代码,你仍然可以从大多数 GPars 功能中受益。Java API 特性

GPars 的某些部分与 Java 无关,最好直接使用底层的 Java 库

- 并行集合 - 直接使用 jsr-166y 库的并行数组

- Fork/Join - 直接使用 jsr-166y 库的 Fork/Join 支持

- 异步函数 - 直接使用 Java 执行程序服务

GPars 的其他部分可以从 Java 中使用,就像从 Groovy 中使用一样,尽管大多数人会错过 Groovy DSL 的功能。

Java API 中的 GPars 闭包

为了克服 Java 中缺少闭包作为语言元素的问题,并避免强迫用户通过 Java API 直接使用 Groovy 闭包,提供了一些方便的包装类来帮助您定义回调、演员主体或数据流任务。

- groovyx.gpars.MessagingRunnable - 用于单参数回调或演员主体

- groovyx.gpars.ReactorMessagingRunnable - 用于 ReactiveActor 主体

- groovyx.gpars.DataflowMessagingRunnable - 用于数据流运算符的主体

这些类可以在 GPars API 预期使用 Groovy 闭包的所有地方使用。

Actor

DynamicDispatchActor 以及 ReactiveActor 类可以像在 Groovy 中一样使用

import groovyx.gpars.MessagingRunnable; import groovyx.gpars.actor.DynamicDispatchActor;public class StatelessActorDemo { public static void main(String[] args) throws InterruptedException { final MyStatelessActor actor = new MyStatelessActor(); actor.start(); actor.send("Hello"); actor.sendAndWait(10); actor.sendAndContinue(10.0, new MessagingRunnable<String>() { @Override protected void doRun(final String s) { System.out.println("Received a reply " + s); } }); } }

class MyStatelessActor extends DynamicDispatchActor { public void onMessage(final String msg) { System.out.println("Received " + msg); replyIfExists("Thank you"); }

public void onMessage(final Integer msg) { System.out.println("Received a number " + msg); replyIfExists("Thank you"); }

public void onMessage(final Object msg) { System.out.println("Received an object " + msg); replyIfExists("Thank you"); } }

尽管 Groovy 和 Java GPars 的使用之间没有太多区别,但请注意,回调实例化 MessagingRunnable 类以代替 groovy 闭包。

import groovy.lang.Closure; import groovyx.gpars.ReactorMessagingRunnable; import groovyx.gpars.actor.Actor; import groovyx.gpars.actor.ReactiveActor;public class ReactorDemo { public static void main(final String[] args) throws InterruptedException { final Closure handler = new ReactorMessagingRunnable<Integer, Integer>() { @Override protected Integer doRun(final Integer integer) { return integer * 2; } }; final Actor actor = new ReactiveActor(handler); actor.start();

System.out.println("Result: " + actor.sendAndWait(1)); System.out.println("Result: " + actor.sendAndWait(2)); System.out.println("Result: " + actor.sendAndWait(3)); } }

便捷工厂方法

显然,所有用于快速构建演员的基本工厂方法都可以在您期望的地方找到。

import groovy.lang.Closure; import groovyx.gpars.ReactorMessagingRunnable; import groovyx.gpars.actor.Actor; import groovyx.gpars.actor.Actors;public class ReactorDemo { public static void main(final String[] args) throws InterruptedException { final Closure handler = new ReactorMessagingRunnable<Integer, Integer>() { @Override protected Integer doRun(final Integer integer) { return integer * 2; } }; final Actor actor = Actors.reactor(handler);

System.out.println("Result: " + actor.sendAndWait(1)); System.out.println("Result: " + actor.sendAndWait(2)); System.out.println("Result: " + actor.sendAndWait(3)); } }

Agent

import groovyx.gpars.MessagingRunnable; import groovyx.gpars.agent.Agent;public class AgentDemo { public static void main(final String[] args) throws InterruptedException { final Agent counter = new Agent<Integer>(0); counter.send(10); System.out.println("Current value: " + counter.getVal()); counter.send(new MessagingRunnable<Integer>() { @Override protected void doRun(final Integer integer) { counter.updateValue(integer + 1); } }); System.out.println("Current value: " + counter.getVal()); } }

数据流并发

从 Java 中使用 DataflowVariables 和 DataflowQueues 都没有问题。只需避免方便的重载运算符,直接使用方法,例如 bind、whenBound、getVal 等。您也可以继续使用数据流 任务,将 Runnable 或 Callable 的实例传递给它们,就像 groovy Closure 一样。

import groovyx.gpars.MessagingRunnable; import groovyx.gpars.dataflow.DataflowVariable; import groovyx.gpars.group.DefaultPGroup;import java.util.concurrent.Callable;

public class DataflowTaskDemo { public static void main(final String[] args) throws InterruptedException { final DefaultPGroup group = new DefaultPGroup(10);

final DataflowVariable a = new DataflowVariable();

group.task(new Runnable() { public void run() { a.bind(10); } });

final Promise result = group.task(new Callable() { public Object call() throws Exception { return (Integer)a.getVal() + 10; } });

result.whenBound(new MessagingRunnable<Integer>() { @Override protected void doRun(final Integer integer) { System.out.println("arguments = " + integer); } });

System.out.println("result = " + result.getVal()); } }

数据流运算符

下面的示例应该说明 Groovy 和 Java API 在数据流运算符方面的主要区别。

- 使用接受通道列表的便捷工厂方法来创建运算符或选择器

- 使用 DataflowMessagingRunnable 指定运算符主体

- 调用 getOwningProcessor() 以从主体内部获取运算符,以便例如绑定输出值

import groovyx.gpars.DataflowMessagingRunnable; import groovyx.gpars.dataflow.Dataflow; import groovyx.gpars.dataflow.DataflowQueue; import groovyx.gpars.dataflow.operator.DataflowProcessor;import java.util.Arrays; import java.util.List;

public class DataflowOperatorDemo { public static void main(final String[] args) throws InterruptedException { final DataflowQueue stream1 = new DataflowQueue(); final DataflowQueue stream2 = new DataflowQueue(); final DataflowQueue stream3 = new DataflowQueue(); final DataflowQueue stream4 = new DataflowQueue();

final DataflowProcessor op1 = Dataflow.selector(Arrays.asList(stream1), Arrays.asList(stream2), new DataflowMessagingRunnable(1) { @Override protected void doRun(final Object… objects) { getOwningProcessor().bindOutput(2*(Integer)objects[0]); } });

final List secondOperatorInput = Arrays.asList(stream2, stream3);

final DataflowProcessor op2 = Dataflow.operator(secondOperatorInput, Arrays.asList(stream4), new DataflowMessagingRunnable(2) { @Override protected void doRun(final Object… objects) { getOwningProcessor().bindOutput((Integer) objects[0] + (Integer) objects[1]); } });

stream1.bind(1); stream1.bind(2); stream1.bind(3); stream3.bind(100); stream3.bind(100); stream3.bind(100); System.out.println("Result: " + stream4.getVal()); System.out.println("Result: " + stream4.getVal()); System.out.println("Result: " + stream4.getVal()); op1.stop(); op2.stop(); } }

性能

一般来说,无论您是使用 Groovy 还是 Java,GPars 的开销都是相同的,并且往往非常低。例如,GPars 演员可以与其他 JVM 演员选项(如 Scala 演员)正面竞争。

由于 Groovy 代码通常比 Java 代码运行速度慢,这主要是因为动态方法调用,因此您可能考虑用 Java 编写代码以提高性能。通常,任务或演员主体内的数值运算或频繁的细粒度方法调用可能会从重写为 Java 中获益。

先决条件

所有 GPars 集成规则都适用于 Java 项目,就像它们适用于 Groovy 项目一样。您只需要将 groovy 分发 jar 文件包含到您的项目中,一切就都清楚了。您也可以查看示例 Java Maven 项目,以获取有关如何将 GPars 集成到基于 maven 的纯 Java 应用程序中的技巧 - 示例 Java Maven 项目

3 数据并行

专注于数据而不是进程,有助于创建健壮的并发程序。作为程序员,您定义数据以及应该应用于它的函数,然后让底层机制处理数据。通常,将创建一组并发任务,然后将它们提交给线程池进行处理。在 GPars 中,GParsPool 和 GParsExecutorsPool 类可以让您访问低级数据并行技术。虽然 GParsPool 类依赖于 jsr-166y Fork/Join 框架,因此提供了更大的功能和更好的性能,但 GParsExecutorsPool 使用的是传统的 Java 执行程序,因此在受管理或受限制的环境中更容易设置。

GPars 低级数据并行涵盖了三个基本领域

- 并发处理集合

- 异步运行函数(闭包)

- 执行 Fork/Join(分治)算法

3.1 并行集合

处理数据通常涉及操作集合。列表、数组、集合、映射、迭代器、字符串以及许多其他数据类型都可以被视为项目的集合。处理此类集合的常见模式是从头到尾依次取元素,对每个项目进行操作。例如,min() 函数应该返回集合中最小的元素。当您在数字集合上调用 min() 方法时,调用者线程将创建一个 累加器 或 到目前为止最小的值,并将其初始化为给定类型的最小值,例如零。然后,线程将遍历集合中的元素,并将它们与 累加器 中的值进行比较。处理完所有元素后,最小值将存储在 累加器 中。

然而,这种算法虽然简单,但对于多核硬件来说 完全错误。在双核芯片上运行 min() 函数最多只能利用芯片 50% 的计算能力。在四核芯片上,它将仅为 25%。没错,该算法实际上 浪费了芯片 75% 的计算能力。

树状结构被证明更适合并行处理。我们示例中的 min() 函数不需要遍历行中的所有元素并将它们的值与 累加器 进行比较。它可以做的是依赖硬件的多核特性。例如,parallel_min() 函数可以比较集合中相邻值的成对(或特定大小的元组),并将元组中最小的值提升到下一轮比较。在不同的元组中搜索最小值可以安全地并行进行,因此同一轮中的元组可以由不同的核心同时处理,而不会出现线程之间的竞争或冲突。

认识并行数组

jsr-166y 库提供了一个非常方便的抽象,称为 并行数组。GPars 以多种方式利用并行数组实现。GParsPool 和 GParsExecutorsPool 类提供了常见 Groovy 迭代方法的并行变体,例如 each()、collect()、findAll() 等。

def selfPortraits = images.findAllParallel{it.contains me}.collectParallel {it.resize()}def smallestSelfPortrait = images.parallel.filter{it.contains me}.map{it.resize()}.min{it.sizeInMB}3.1.1 GParsPool

使用 GParsPool - 基于 JSR-166y 的并发集合处理器GParsPool 的用法

GParsPool 类为集合和对象提供了基于并行数组(来自 JSR-166y)的并发 DSL。

使用示例

//summarize numbers concurrently

GParsPool.withPool {

final AtomicInteger result = new AtomicInteger(0)

[1, 2, 3, 4, 5].eachParallel {result.addAndGet(it)}

assert 15 == result

} //multiply numbers asynchronously

GParsPool.withPool {

final List result = [1, 2, 3, 4, 5].collectParallel {it * 2}

assert ([2, 4, 6, 8, 10].equals(result))

}

//check whether all elements within a collection meet certain criteria

GParsPool.withPool(5) {ForkJoinPool pool ->

assert [1, 2, 3, 4, 5].everyParallel {it > 0}

assert ![1, 2, 3, 4, 5].everyParallel {it > 1}

}withPool(10) {...}

withPool(20, exceptionHandler) {...}GParsPool.withExistingPool() 接受一个已存在的 ForkJoinPool 实例以供重用。DSL 仅在关联的代码块内有效,并且仅对调用了 withPool() 或 withExistingPool() 方法的线程有效。 withPool() 方法只有在所有工作线程完成其任务并且池被销毁后才会返回,返回关联代码块的返回值。 withExistingPool() 方法不会等待池线程完成。

或者,可以静态导入 GParsPool 类 import static groovyx.gpars.GParsPool.`*`,这将允许省略 GParsPool 类名。

withPool {

assert [1, 2, 3, 4, 5].everyParallel {it > 0}

assert ![1, 2, 3, 4, 5].everyParallel {it > 1}

}以下方法当前在 Groovy 中的所有对象上都受支持

- eachParallel()

- eachWithIndexParallel()

- collectParallel()

- collectManyParallel()

- findAllParallel()

- findAnyParallel

- findParallel()

- everyParallel()

- anyParallel()

- grepParallel()

- groupByParallel()

- foldParallel()

- minParallel()

- maxParallel()

- sumParallel()

- splitParallel()

- countParallel()

- foldParallel()

元类增强器

作为替代方案,可以使用 ParallelEnhancer 类来增强任何类或单个实例的元类,并使用并行方法。

import groovyx.gpars.ParallelEnhancerdef list = [1, 2, 3, 4, 5, 6, 7, 8, 9] ParallelEnhancer.enhanceInstance(list) println list.collectParallel {it * 2 }

def animals = ['dog', 'ant', 'cat', 'whale'] ParallelEnhancer.enhanceInstance animals println (animals.anyParallel {it ==~ /ant/} ? 'Found an ant' : 'No ants found') println (animals.everyParallel {it.contains('a')} ? 'All animals contain a' : 'Some animals can live without an a')

异常处理

如果在处理任何传入的闭包时抛出异常,则第一个异常将从 xxxParallel 方法中重新抛出,并且算法将在尽快停止。

GParsPool 的异常处理机制建立在 Fork/Join 框架中内置的机制之上。由于 Fork/Join 算法本质上是分层的,一旦算法的任何部分发生故障,继续计算通常没有太大好处,因为算法的某些分支将永远不会返回结果。请记住,GParsPool 实现不保证在发生第一个未处理异常后的行为,除了停止算法并将第一个检测到的异常重新抛出给调用者之外。毕竟,这种行为与传统的顺序迭代方法所做的一致。

透明并行集合

除了添加新的 xxxParallel() 方法之外,GPars 还允许您更改原始迭代方法的语义。例如,您可能将集合传递到一个库方法中,该方法将以顺序方式处理您的集合,例如使用 collect() 方法。通过更改集合上的 collect() 方法的语义,您可以有效地并行化库顺序代码。

GParsPool.withPool { //The selectImportantNames() will process the name collections concurrently

assert ['ALICE', 'JASON'] == selectImportantNames(['Joe', 'Alice', 'Dave', 'Jason'].makeConcurrent())

}

/**

* A function implemented using standard sequential collect() and findAll() methods.

*/

def selectImportantNames(names) {

names.collect {it.toUpperCase()}.findAll{it.size() > 4}

}

makeSequential() 方法将重置集合以返回到原始的顺序语义。

import static groovyx.gpars.GParsPool.withPooldef list = [1, 2, 3, 4, 5, 6, 7, 8, 9]

println 'Sequential: ' list.each { print it + ',' } println()

withPool {

println 'Sequential: ' list.each { print it + ',' } println()

list.makeConcurrent()

println 'Concurrent: ' list.each { print it + ',' } println()

list.makeSequential()

println 'Sequential: ' list.each { print it + ',' } println() }

println 'Sequential: ' list.each { print it + ',' } println()

asConcurrent() 方便方法将允许您指定代码块,在这些代码块中集合保持并发语义。

import static groovyx.gpars.GParsPool.withPooldef list = [1, 2, 3, 4, 5, 6, 7, 8, 9]

println 'Sequential: ' list.each { print it + ',' } println()

withPool {

println 'Sequential: ' list.each { print it + ',' } println()

list.asConcurrent { println 'Concurrent: ' list.each { print it + ',' } println() }

println 'Sequential: ' list.each { print it + ',' } println() }

println 'Sequential: ' list.each { print it + ',' } println()

透明并行化,包括 makeConcurrent()、makeSequential() 和 asConcurrent() 方法,也可以与 ParallelEnhancer 结合使用。

/**

* A function implemented using standard sequential collect() and findAll() methods.

*/

def selectImportantNames(names) {

names.collect {it.toUpperCase()}.findAll{it.size() > 4}

}def names = ['Joe', 'Alice', 'Dave', 'Jason']

ParallelEnhancer.enhanceInstance(names)

//The selectImportantNames() will process the name collections concurrently

assert ['ALICE', 'JASON'] == selectImportantNames(names.makeConcurrent())

import groovyx.gpars.ParallelEnhancerdef list = [1, 2, 3, 4, 5, 6, 7, 8, 9]

println 'Sequential: ' list.each { print it + ',' } println()

ParallelEnhancer.enhanceInstance(list)

println 'Sequential: ' list.each { print it + ',' } println()

list.asConcurrent { println 'Concurrent: ' list.each { print it + ',' } println()

} list.makeSequential()

println 'Sequential: ' list.each { print it + ',' } println()

避免函数中的副作用

我们必须提醒您。由于提供给并行方法(例如 eachParallel() 或 collectParallel())的闭包可能并行运行,因此您必须确保每个闭包都以线程安全的方式编写。闭包不得持有任何内部状态、共享数据或具有超出调用其单个元素边界的副作用。违反这些规则将为竞争条件和死锁打开大门,它们是现代多核程序员最严重的敌人。

不要这样做

def thumbnails = []

images.eachParallel {thumbnails << it.thumbnail} //Concurrently accessing a not-thread-safe collection of thumbnails, don't do this!因为 GParsPool 使用 Fork/Join 池(带工作窃取),即使线程可能看起来处于空闲状态,它们也可能不会应用于等待处理的任务。使用工作窃取算法,用完任务的工作线程可以从仍然忙碌的其他线程中窃取任务。如果您使用 GParsExecutorsPool,它不使用 Fork/Join,则您会获得您天真地期望的线程分配行为。

3.1.2 GParsExecutorsPool

使用 GParsExecutorsPool - 基于 Java Executors 的并发集合处理器GParsExecutorsPool 的用法

GParsExecutorsPool 类为集合和对象提供了基于 Java Executors 的并发 DSL。

GParsExecutorsPool 类可用作纯 JDK 基于的集合并行处理器。与 GParsPool 类不同,GParsExecutorsPool 不需要 jsr-166y jar 文件,但利用标准 JDK 执行器服务来并行化迭代处理集合或对象的闭包。但是,需要说明的是,GParsPool 的性能通常比 GParsExecutorsPool 好得多。

使用示例

//multiply numbers asynchronously

GParsExecutorsPool.withPool {

Collection<Future> result = [1, 2, 3, 4, 5].collectParallel{it * 10}

assert new HashSet([10, 20, 30, 40, 50]) == new HashSet((Collection)result*.get())

} //multiply numbers asynchronously using an asynchronous closure

GParsExecutorsPool.withPool {

def closure={it * 10}

def asyncClosure=closure.async()

Collection<Future> result = [1, 2, 3, 4, 5].collect(asyncClosure)

assert new HashSet([10, 20, 30, 40, 50]) == new HashSet((Collection)result*.get())

}

//find an element meeting specified criteria

GParsExecutorsPool.withPool(5) {ExecutorService service ->

service.submit({performLongCalculation()} as Runnable)

}withPool(10) {...}

withPool(20, threadFactory) {...}GParsExecutorsPool.withExistingPool() 接受一个已存在的执行器服务实例以供重用。DSL 仅在关联的代码块内有效,并且仅对调用了 withPool() 或 withExistingPool() 方法的线程有效。 withPool() 方法只有在所有工作线程完成其任务并且执行器服务被销毁后才会返回,返回关联代码块的返回值。 withExistingPool() 方法不会等待执行器服务线程完成。

或者,可以静态导入 GParsExecutorsPool 类 import static groovyx.gpars.GParsExecutorsPool.`*`,这将允许省略 GParsExecutorsPool 类名。

withPool {

def result = [1, 2, 3, 4, 5].findParallel{Number number -> number > 2}

assert result in [3, 4, 5]

}- eachParallel()

- eachWithIndexParallel()

- collectParallel()

- findAllParallel()

- findParallel()

- allParallel()

- anyParallel()

- grepParallel()

- groupByParallel()

元类增强器

作为替代方案,可以使用 GParsExecutorsPoolEnhancer 类来增强任何类或单个实例的元类,并使用异步方法。

import groovyx.gpars.GParsExecutorsPoolEnhancerdef list = [1, 2, 3, 4, 5, 6, 7, 8, 9] GParsExecutorsPoolEnhancer.enhanceInstance(list) println list.collectParallel {it * 2 }

def animals = ['dog', 'ant', 'cat', 'whale'] GParsExecutorsPoolEnhancer.enhanceInstance animals println (animals.anyParallel {it ==~ /ant/} ? 'Found an ant' : 'No ants found') println (animals.allParallel {it.contains('a')} ? 'All animals contain a' : 'Some animals can live without an a')

使用 GParsExecutorsPoolEnhancer 类时,您无需使用 GParsExecutorsPool DSL 限制在 withPool() 块中。增强后的类或实例将一直保持增强状态,直到它们被垃圾回收。

异常处理

如果在处理任何传入的闭包时抛出异常,则将重新抛出包装所有原始异常的 AsyncException 实例,从 xxxParallel 方法抛出。

避免函数中的副作用

我们再次需要提醒您,不要使用具有副作用的闭包来影响超出当前处理元素范围的对象,或者保持状态的闭包。不要这样做!将它们传递给任何 xxxParallel() 方法都是危险的。

3.1.3 记忆化

memoize 函数允许缓存函数的返回值。对记忆化函数的重复调用,如果使用相同的参数值,将不会调用原始函数中编码的计算,而是从内部透明缓存中检索结果值。如果计算明显比从缓存中检索缓存值慢,这将允许用户以内存换取性能。查看示例,我们将尝试扫描多个网站以查找特定内容GPars 的记忆化功能已在 Groovy 1.8 版本中贡献,如果您在 Groovy 1.8 或更高版本上运行,建议使用 Groovy 功能。GPars 中的记忆化几乎相同,只是它使用周围的线程池并发地搜索记忆化缓存,因此在某些情况下可能会带来性能优势。

GPars 记忆化功能已重命名,以避免与 Groovy 中的记忆化功能发生将来冲突。GPars 现在使用前缀字母 g 调用方法,例如 gmemoize()。

使用示例

GParsPool.withPool {

def urls = ['http://www.dzone.com', 'http://www.theserverside.com', 'http://www.infoq.com']

Closure download = {url ->

println "Downloading $url"

url.toURL().text.toUpperCase()

}

Closure cachingDownload = download.gmemoize() println 'Groovy sites today: ' + urls.findAllParallel {url -> cachingDownload(url).contains('GROOVY')}

println 'Grails sites today: ' + urls.findAllParallel {url -> cachingDownload(url).contains('GRAILS')}

println 'Griffon sites today: ' + urls.findAllParallel {url -> cachingDownload(url).contains('GRIFFON')}

println 'Gradle sites today: ' + urls.findAllParallel {url -> cachingDownload(url).contains('GRADLE')}

println 'Concurrency sites today: ' + urls.findAllParallel {url -> cachingDownload(url).contains('CONCURRENCY')}

println 'GPars sites today: ' + urls.findAllParallel {url -> cachingDownload(url).contains('GPARS')}

}

请注意,闭包在 GParsPool.withPool() 块中使用 memoize() 函数增强,该函数返回一个新的闭包,该闭包使用缓存包装原始闭包。在示例中,我们在代码中调用了 cachingDownload 函数,但是,每个唯一的 url 仅下载一次 - 第一次需要它时。然后缓存这些值,并可供后续调用使用。以及所有线程,无论哪个线程最初使用特定 url 的下载请求并必须处理实际计算/下载。

因此,总结一下,记忆化通过过去返回值的缓存来保护函数。但是,memoize 可以做得更多。在某些算法中,添加少量内存可能会对计算的计算复杂度产生巨大影响。让我们看一个经典的斐波那契数示例。

斐波那契示例

一个纯粹的函数式递归实现,紧密遵循斐波那契数的定义,是指数级的复杂度

Closure fib = {n -> n > 1 ? call(n - 1) + call(n - 2) : n}尝试使用大约 30 的数字调用 fib 函数,您将看到它有多慢。

现在,稍加调整并添加记忆化缓存,算法神奇地变成了线性复杂度

Closure fib

fib = {n -> n > 1 ? fib(n - 1) + fib(n - 2) : n}.gmemoize()我们添加的额外内存切断了除一个递归分支之外的所有分支。所有后续对相同 fib 函数的调用也将从缓存的值中受益。

此外,请参见下面,memoizeAtMost 变体如何在我们的示例中减少内存消耗,同时保留算法的线性复杂度。

可用变体

memoize

基本变体,它在记忆化函数的整个生命周期内将值保留在内部缓存中。提供所有变体中最佳的性能特征。

memoizeAtMost

允许用户为缓存的项目数量设置硬限制。一旦达到限制,所有随后添加的值将使用 LRU(最近最少使用)策略从缓存中消除最旧的值。

因此,对于我们的斐波那契数示例,我们可以安全地将缓存大小缩减为两个项目。

Closure fib

fib = {n -> n > 1 ? fib(n - 1) + fib(n - 2) : n}.memoizeAtMost(2)对缓存大小设置上限可能有两个目的。

- 将缓存的内存占用量保持在定义的范围内。

- 保留函数所需的性能特征。过大的缓存可能需要更长的时间来检索缓存的值,而直接计算结果所花的时间更短。

memoizeAtLeast

允许内部缓存无限增长,直到 JVM 的垃圾收集器决定介入并从内存中逐出 SoftReferences(我们的实现使用)。memoizeAtLeast() 方法的单个参数值指定应保护免受 gc 逐出的最小缓存项目数。缓存永远不会缩小到指定的条目数以下。缓存确保它仅使用 LRU(最近最少使用)策略保护最近使用的项目免受逐出。

memoizeBetween

结合了 memoizeAtLeast 和 memoizeAtMost,因此允许缓存根据可用内存和 gc 活动在两个参数值之间的范围内增长和缩小,但缓存大小永远不会超过上限以保留缓存所需的性能特征。

3.2 地图减少

并行集合 Map/Reduce DSL 为 GPars 带来了更具功能性的风格。一般来说,Map/Reduce DSL 可用于与xxxParallel() 系列方法相同的目的,并且具有非常相似的语义。另一方面,如果您需要将多个方法链接起来以在多个步骤中处理单个集合,则 Map/Reduce 可以执行得快得多。println 'Number of occurrences of the word GROOVY today: ' + urls.parallel

.map {it.toURL().text.toUpperCase()}

.filter {it.contains('GROOVY')}

.map{it.split()}

.map{it.findAll{word -> word.contains 'GROOVY'}.size()}

.sum()xxxParallel() 方法必须遵循其非并行对等方法的约定。因此,collectParallel() 方法必须返回一个合法项目的集合,您可以再次将其视为 Groovy 集合。在内部,并行收集方法构建了一个高效的并行结构,称为并行数组,并发地执行所需的操作,并在返回之前销毁并行数组,构建要返回给您的结果集合。对结果集合进行 let say findAllParallel() 的潜在调用将重复在后台进行并行数组实例的构建和销毁的整个过程。

使用 Map/Reduce,您只需将集合转换为并行数组并返回一次。Map/Reduce 系列方法不返回 Groovy 集合,而是可以自由地直接传递内部并行数组。在集合上调用parallel 属性将为集合构建一个并行数组,并返回一个围绕并行数组实例的薄包装器。然后,您可以链接所有必需的方法,如

- map()

- reduce()

- filter()

- size()

- sum()

- min()

- max()

- sort()

- groupBy()

- combine()

返回到普通的 Groovy 集合实例始终只是检索collection 属性的问题。

def myNumbers = (1..1000).parallel.filter{it % 2 == 0}.map{Math.sqrt it}.collection避免函数中的副作用

我们再次需要提醒您。为了避免出现意外情况,请保持传递给 Map/Reduce 函数的闭包无状态且没有副作用。

可用性

此功能仅在使用基于 Fork/Join 的GParsPool 时可用,在GParsExecutorsPool 中不可用。

经典示例

一个经典的示例,受 http://github.com/thevery 启发,计算字符串中单词的出现次数

import static groovyx.gpars.GParsPool.withPooldef words = "This is just a plain text to count words in" print count(words)

def count(arg) { withPool { return arg.parallel .map{[it, 1]} .groupBy{it[0]}.getParallel() .map {it.value=it.value.size();it} .sort{-it.value}.collection } }

同一个示例,现在用更通用的combine 操作实现

def words = "This is just a plain text to count words in" print count(words)def count(arg) { withPool { return arg.parallel .map{[it, 1]} .combine(0) {sum, value -> sum + value}.getParallel() .sort{-it.value}.collection } }

组合

combine 操作期望其输入是一个元组列表(两个元素列表),被认为是键值对(如 [key1, value1, key2, value2, key1, value3, key3, value4 … ]),其中可能包含重复键。调用时,combine 使用提供的累加器函数合并相同键的值,并生成一个映射原始(唯一)键与其累积值的映射。例如,[a, b, c, d, a, e, c, f] 将被组合成 a : b+e, c : d+f,而值上的 '+' 操作需要由用户作为累加闭包提供。

累加器函数 参数需要指定一个函数,用于组合(累加)属于同一个键的值。还需要提供初始累加器值。由于combine 方法并行处理项目,因此将多次重复使用初始累加器值。因此,提供的值必须允许重复使用。它应该是一个可克隆的或不可变的值,或者是一个闭包,每次请求时返回一个新的初始累加器。累加器函数和可重复使用的初始值的良好组合包括

accumulator = {List acc, value -> acc << value} initialValue = []

accumulator = {List acc, value -> acc << value} initialValue = {-> []}

accumulator = {int sum, int value -> acc + value} initialValue = 0

accumulator = {int sum, int value -> sum + value} initialValue = {-> 0}

accumulator = {ShoppingCart cart, Item value -> cart.addItem(value)} initialValue = {-> new ShoppingCart()}返回值类型为映射。例如,['he', 1, 'she', 2, 'he', 2, 'me', 1, 'she, 5, 'he', 1 与提供的初始值为 0 将被组合成 'he' : 4, 'she' : 7, 'he', : 2, 'me' : 1

键将使用它们的 equals 和 hashCode 方法相互比较。考虑使用@Canonical 或@EqualsAndHashCode 来注释用作键的类。就像 Groovy 中的所有哈希映射一样,请确保使用的是字符串而不是 GString 作为键!

对于更复杂的场景,当您combine() 复杂对象时,这里一个好的策略是拥有一个类,该类可以用作常见用例的键,并为不常见用例应用不同的键。

import groovy.transform.ToString import groovy.transform.TupleConstructorimport static groovyx.gpars.GParsPool.withPool

TupleConstructorToString class PricedCar implements Cloneable { String model String color Double priceboolean equals(final o) { if (this.is(o)) return true if (getClass() != o.class) return false

final PricedCar pricedCar = (PricedCar) o

if (color != pricedCar.color) return false if (model != pricedCar.model) return false

return true }

int hashCode() { int result result = (model != null ? model.hashCode() : 0) result = 31 * result + (color != null ? color.hashCode() : 0) return result }

@Override protected Object clone() { return super.clone() } }

def cars = [new PricedCar('F550', 'blue', 2342.223), new PricedCar('F550', 'red', 234.234), new PricedCar('Da', 'white', 2222.2), new PricedCar('Da', 'white', 1111.1)]

withPool { //Combine by model def result = cars.parallel.map { [it.model, it] }.combine(new PricedCar('', 'N/A', 0.0)) {sum, value -> sum.model = value.model sum.price += value.price sum }.values()

println result

//Combine by model and color (the PricedCar's equals and hashCode)) result = cars.parallel.map { [it, it] }.combine(new PricedCar('', 'N/A', 0.0)) {sum, value -> sum.model = value.model sum.color = value.color sum.price += value.price sum }.values()

println result }

3.3 并行数组

作为替代方案,可以直接使用 JSR-166y 中定义的高效树状数据结构。任何集合或对象上的parallelArray 属性将返回一个jsr166y.forkjoin.ParallelArray 实例,该实例保存原始集合的元素,然后可以通过 jsr166y API 对其进行操作。有关 API 详细信息,请参阅 jsr166y 文档。import groovyx.gpars.extra166y.Opsgroovyx.gpars.GParsPool.withPool { assert 15 == [1, 2, 3, 4, 5].parallelArray.reduce({a, b -> a + b} as Ops.Reducer, 0) //summarize assert 55 == [1, 2, 3, 4, 5].parallelArray.withMapping({it ** 2} as Ops.Op).reduce({a, b -> a + b} as Ops.Reducer, 0) //summarize squares assert 20 == [1, 2, 3, 4, 5].parallelArray.withFilter({it % 2 == 0} as Ops.Predicate) //summarize squares of even numbers .withMapping({it ** 2} as Ops.Op) .reduce({a, b -> a + b} as Ops.Reducer, 0)

assert 'aa:bb:cc:dd:ee' == 'abcde'.parallelArray //concatenate duplicated characters with separator .withMapping({it * 2} as Ops.Op) .reduce({a, b -> "$a:$b"} as Ops.Reducer, "")

3.4 异步调用

在后台运行长时间运行的任务属于活动,对这些任务的需求非常频繁。您的主执行线程希望初始化一些计算、下载、搜索或类似的操作,但是,可能不需要立即获得结果。GPars 为开发人员提供了工具,可以安排在后台处理异步活动,并在需要时收集结果。GParsPool 和 GParsExecutorsPool 异步处理功能的使用

GParsPool 和GParsExecutorsPool 都在此领域提供几乎相同的服务,尽管它们利用了不同的底层机制,这取决于用户选择这两个类中的哪一个。

闭包增强

以下方法已添加到GPars(Executors)Pool.withPool() 块内的闭包中。

- async() - 创建提供的闭包的异步变体,该变体在调用时返回潜在返回值的未来。

- callAsync() - 在单独的线程中调用闭包,提供给定的参数,返回潜在返回值的未来。

示例

GParsPool.withPool() {

Closure longLastingCalculation = {calculate()}

Closure fastCalculation = longLastingCalculation.async() //create a new closure, which starts the original closure on a thread pool

Future result=fastCalculation() //returns almost immediately

//do stuff while calculation performs …

println result.get()

}GParsPool.withPool() {

/**

* The callAsync() method is an asynchronous variant of the default call() method to invoke a closure.

* It will return a Future for the result value.

*/

assert 6 == {it * 2}.call(3)

assert 6 == {it * 2}.callAsync(3).get()

}超时

callTimeoutAsync() 方法(接受 long 值或 Duration 实例)允许用户在给定时间间隔后取消计算。

{->

while(true) {

Thread.sleep 1000 //Simulate a bit of interesting calculation

if (Thread.currentThread().isInterrupted()) break; //We've been cancelled

}

}.callTimeoutAsync(2000)为了允许取消,异步运行的代码必须不断检查其自身线程的interrupted 标志,并在标志设置为 true 时停止计算。

执行器服务增强

ExecutorService 和 jsr166y.forkjoin.ForkJoinPool 类使用 <<(左移)运算符进行增强,以将任务提交到池中并返回结果的Future。

示例

GParsExecutorsPool.withPool {ExecutorService executorService ->

executorService << {println 'Inside parallel task'}

}并行运行函数(闭包)

GParsPool 和GParsExecutorsPool 类还提供便捷方法executeAsync() 和executeAsyncAndWait(),以便轻松异步运行多个闭包。

示例

GParsPool.withPool {

assert [10, 20] == GParsPool.executeAsyncAndWait({calculateA()}, {calculateB()} //waits for results

assert [10, 20] == GParsPool.executeAsync({calculateA()}, {calculateB()})*.get() //returns Futures instead and doesn't wait for results to be calculated

}3.5 可组合的异步函数

函数应该被组合。事实上,组合无副作用函数非常容易。比组合对象容易得多,而且更可靠,例如。给定相同的输入,函数始终返回相同的结果,它们不会以意外的方式改变其行为,也不会在多个线程同时调用它们时崩溃。Groovy 中的函数

我们可以将 Groovy 闭包视为函数。它们接受参数,执行计算并返回值。假设您不让自己闭包接触其作用域之外的任何内容,那么您的闭包将是行为良好的纯函数。您可以组合起来更好地使用的函数。def sum = (0..100000).inject(0, {a, b -> a + b})def max = myNumbers.inject(0, {a, b -> a>b?a:b})您会发现,函数式编程之所以流行是有原因的。

我们并发了吗?

这一切都运行良好,直到您意识到您没有充分利用昂贵的硬件的全部能力。函数是纯粹的顺序。这里没有并行性。除了一个处理器核心外,所有核心都无所事事,它们处于空闲状态,完全被浪费了。那些注意的人会建议使用前面描述的并行集合技术,他们当然是对的。对于我们这里描述的场景,我们处理集合,使用那些parallel 方法将是最佳选择。但是,我们现在正在寻找一种创建和组合异步函数的通用方法,这将不仅帮助我们进行集合处理,而且主要是在其他更通用的情况下,就像下面将要介绍的那样。为了使事情更清楚,这里有一个组合四个函数的示例,这些函数应该检查特定的网页是否与本地文件的原始内容匹配。我们需要下载页面,加载文件,计算两者的哈希值,最后比较结果值。

Closure download = {String url ->

url.toURL().text

}Closure loadFile = {String fileName ->

… //load the file here

}

Closure hash = {s -> s.hashCode()}

Closure compare = {int first, int second ->

first == second

}

def result = compare(hash(download('http://www.gpars.org')), hash(loadFile('/coolStuff/gpars/website/index.html')))

println "The result of comparison: " + result

使这一切都异步

我们代码的缺点是我们没有利用download() 和loadFile() 函数的独立性。我们也不允许两个哈希值同时运行。它们完全可以并行运行,但我们组合函数的方式限制了任何并行性。

显然,并非所有函数都可以同时运行。有些函数依赖于其他函数的结果。它们不能在另一个函数完成之前开始。我们需要阻塞它们,直到它们的参数可用。hash() 函数需要一个字符串来处理。compare() 函数需要两个数字进行比较。

因此,我们只能并行化一些函数,而阻塞其他函数的并行性。看起来这是一个具有挑战性的任务。

函数式世界一片光明

幸运的是,函数之间的依赖关系已经在代码中隐式地表达出来了。我们不需要重复依赖关系信息。如果一个函数接受参数,而这些参数需要先由另一个函数计算,那么我们隐式地在这里存在依赖关系。在我们的例子中,hash() 函数依赖于 loadFile() 以及 download() 函数。在我们之前的例子中,inject 函数依赖于对集合中所有元素逐个调用 addition 函数的结果。

尽管一开始可能看起来很困难,但我们的任务实际上很简单。我们只需要教会我们的函数返回其未来结果的promises。我们还需要教会其他函数接受这些promises 作为参数,以便它们在开始工作之前等待真实的值。如果我们说服函数在等待值时释放它们持有的线程,我们就会直接到达魔法发生的地方。

秉承GPars 的优良传统,我们让您说服任何函数相信其他函数的承诺变得非常简单。在闭包上调用 asyncFun() 函数,您就异步了。

withPool {

def maxPromise = numbers.inject(0, {a, b -> a>b?a:b}.asyncFun())

println "Look Ma, I can talk to the user while the math is being done for me!"

println maxPromise.get()

}inject 函数并不关心 addition 函数返回什么对象,也许它只是有点惊讶每次调用 addition 函数都返回得如此快,但并没有抱怨太多,继续迭代,最终将最终结果返回给您。

现在,这是您应该坚持自己所说并做您想让别人做的事情的时候了。不要对结果皱眉,只要接受您得到了一个承诺。一个承诺,在计算完成时尽快交付结果。从您的笔记本电脑中散发出的额外热量表明,该计算利用了您函数中的自然并行性,并尽最大努力快速将结果交付给您。

promise 是一个老式的 DataflowVariable,因此您可以查询其状态、注册通知钩子或将其作为数据流算法的输入。

withPool {

def sumPromise = (0..100000).inject(0, {a, b -> a + b}.asyncFun())

println "Are we done yet? " + sumPromise.bound

sumPromise.whenBound {sum -> println sum}

}get() 方法还具有一个带有超时参数的变体,如果您想避免无限期等待的风险。

事情会出错吗?

当然。但是您会从结果承诺 get() 方法中抛出一个异常。

try { sumPromise.get() } catch (MyCalculationException e) { println "Guess, things are not ideal today." }

这一切都很好,但是哪些函数可以真正组合起来呢?

没有限制。您可以将任何需要组合的顺序函数组合起来,并且也应该能够组合它们的异步变体。

回到我们最初的例子,比较文件内容和网页内容,我们只需通过对所有函数调用 asyncFun() 方法将它们全部设为异步,我们就可以出发了。

Closure download = {String url ->

url.toURL().text

}.asyncFun() Closure loadFile = {String fileName ->

… //load the file here

}.asyncFun()

Closure hash = {s -> s.hashCode()}.asyncFun()

Closure compare = {int first, int second ->

first == second

}.asyncFun()

def result = compare(hash(download('http://www.gpars.org')), hash(loadFile('/coolStuff/gpars/website/index.html')))

println 'Allowed to do something else now'

println "The result of comparison: " + result.get()

从异步函数内部调用异步函数

异步函数的另一个非常有价值的特性是,它们的 result promises 也可以被组合。

import static groovyx.gpars.GParsPool.withPoolwithPool { Closure plus = {Integer a, Integer b -> sleep 3000 println 'Adding numbers' a + b }.asyncFun()

Closure multiply = {Integer a, Integer b -> sleep 2000 a * b }.asyncFun()

Closure measureTime = {-> sleep 3000 4 }.asyncFun()

Closure distance = {Integer initialDistance, Integer velocity, Integer time -> plus(initialDistance, multiply(velocity, time)) }.asyncFun()

Closure chattyDistance = {Integer initialDistance, Integer velocity, Integer time -> println 'All parameters are now ready - starting' println 'About to call another asynchronous function' def innerResultPromise = plus(initialDistance, multiply(velocity, time)) println 'Returning the promise for the inner calculation as my own result' return innerResultPromise }.asyncFun()

println "Distance = " + distance(100, 20, measureTime()).get() + ' m' println "ChattyDistance = " + chattyDistance(100, 20, measureTime()).get() + ' m' }

如果一个异步函数(例如示例中的 distance 函数)在其主体中调用另一个异步函数(例如 plus)并返回调用的函数的 promise,则内部函数(plus)的结果 promise 将与外部函数(distance)的结果 promise 组合。内部函数(plus)现在将将其结果绑定到外部函数(distance)的 promise 上,一旦内部函数(plus)完成计算。这种 promises 组合的能力允许函数在等待参数时以及在函数体内任何地方调用另一个异步函数时停止计算,而不会阻塞线程。

方法作为异步函数

方法可以使用 .& 运算符引用为闭包。然后,这些闭包可以使用 asyncFun 转换为可组合的异步函数,就像普通的闭包一样。

class DownloadHelper {

String download(String url) {

url.toURL().text

} int scanFor(String word, String text) {

text.findAll(word).size()

}

String lower(s) {

s.toLowerCase()

}

}

//now we'll make the methods asynchronous

withPool {

final DownloadHelper d = new DownloadHelper()

Closure download = d.&download.asyncFun()

Closure scanFor = d.&scanFor.asyncFun()

Closure lower = d.&lower.asyncFun()

//asynchronous processing

def result = scanFor('groovy', lower(download('http://www.infoq.com')))

println 'Allowed to do something else now'

println result.get()

}

使用注解创建异步函数

与其调用 asyncFun() 函数,不如使用 @AsyncFun 注解来注释 Closure 类型的字段。这些字段必须在原地初始化,并且包含类需要在 withPool 块中实例化。

import static groovyx.gpars.GParsPool.withPool import groovyx.gpars.AsyncFunclass DownloadingSearch { @AsyncFun Closure download = {String url -> url.toURL().text }

@AsyncFun Closure scanFor = {String word, String text -> text.findAll(word).size() }

@AsyncFun Closure lower = {s -> s.toLowerCase()}

void scan() { def result = scanFor('groovy', lower(download('http://www.infoq.com'))) //synchronous processing println 'Allowed to do something else now' println result.get() } }

withPool { new DownloadingSearch().scan() }

替代池

AsyncFun 注解默认情况下使用来自包装 withPool 块的 GParsPool 实例。但是,您也可以显式指定池类型。

@AsyncFun(GParsExecutorsPoolUtil) def sum6 = {a, b -> a + b }通过注解阻塞函数

AsyncFun 还允许用户指定生成的函数应该具有阻塞(true)还是非阻塞(false - 默认)语义。

@AsyncFun(blocking = true)

def sum = {a, b -> a + b }显式和延迟池分配

当直接使用 GPars(Executors)PoolUtil.asyncFun() 函数创建异步函数时,您有两个额外的选项将线程池分配给函数。

- 可以在创建时将函数要使用的线程池作为附加参数显式指定。

- 可以从周围的范围内在调用时而不是在创建时获取隐式线程池。

当显式指定线程池时,调用不需要包装在 withPool() 块中。

Closure sPlus = {Integer a, Integer b ->

a + b

}Closure sMultiply = {Integer a, Integer b ->

sleep 2000

a * b

}

println "Synchronous result: " + sMultiply(sPlus(10, 30), 100)

final pool = new FJPool()

Closure aPlus = GParsPoolUtil.asyncFun(sPlus, pool)

Closure aMultiply = GParsPoolUtil.asyncFun(sMultiply, pool)

def result = aMultiply(aPlus(10, 30), 100)

println "Time to do something else while the calculation is running"

println "Asynchronous result: " + result.get()

对于延迟池分配,只有函数调用必须用 withPool() 块包围。

Closure aPlus = GParsPoolUtil.asyncFun(sPlus) Closure aMultiply = GParsPoolUtil.asyncFun(sMultiply)withPool { def result = aMultiply(aPlus(10, 30), 100)

println "Time to do something else while the calculation is running" println "Asynchronous result: " + result.get() }

在我们看来,这是一个非常有趣的探索领域,因此欢迎您对组合异步函数的任何评论、问题或建议,或者关于其限制的提示。

3.6 Fork-Join

Fork/Join 或分治是一种非常强大的抽象,可以解决层次问题。抽象

当谈到层次问题时,想想快速排序、归并排序、文件系统或一般树导航等。

- Fork/Join 算法本质上将手头的問題分成几个较小的子问题,并将相同算法递归地应用于每个子问题。

- 一旦子问题足够小,就会直接解决。

- 所有子问题的解决方案组合起来解决它们父问题,进而帮助解决其自身的父问题。

查看漂亮的交互式 Fork/Join 可视化演示,它将向您展示线程如何协作解决常见的划分和征服算法。

强大的JSR-166y 库为我们很好地解决了 Fork/Join 编排问题,但留下了几个粗糙的边缘,如果您没有足够注意,可能会伤害您。您仍然要处理线程、池或同步屏障。

GPars 抽象便利层

GPars 可以隐藏您处理线程、池和递归任务的复杂性,但仍可以让您利用 jsr166y 中强大的 Fork/Join 实现。

import static groovyx.gpars.GParsPool.runForkJoin import static groovyx.gpars.GParsPool.withPoolwithPool() { println """Number of files: ${ runForkJoin(new File("./src")) {file -> long count = 0 file.eachFile { if (it.isDirectory()) { println "Forking a child task for $it" forkOffChild(it) //fork a child task } else { count++ } } return count + (childrenResults.sum(0)) //use results of children tasks to calculate and store own result } }""" }

runForkJoin() 工厂方法将使用提供的递归代码以及提供的 value,构建一个层次化的 Fork/Join 计算。传递给 runForkJoin() 方法的值数量必须与闭包的预期参数数量以及传递给 forkOffChild() 或 runChildDirectly() 方法的参数数量相匹配。

def quicksort(numbers) {

withPool {

runForkJoin(0, numbers) {index, list ->

def groups = list.groupBy {it <=> list[list.size().intdiv(2)]}

if ((list.size() < 2) || (groups.size() == 1)) {

return [index: index, list: list.clone()]

}

(-1..1).each {forkOffChild(it, groups[it] ?: [])}

return [index: index, list: childrenResults.sort {it.index}.sum {it.list}]

}.list

}

}这里需要提到的一个重要部分是,forkOffChild() 不会等待子任务运行。它只是安排它在将来的某个时间执行。如果一个子任务由于抛出异常而失败,您不应该期望异常从 forkOffChild() 方法本身抛出。异常很可能在父任务从调用 forkOffChild() 方法返回后很久才会发生。它是 getChildrenResults() 方法,它将重新抛出子任务中发生的异常回父任务。

替代方法

或者,可以直接使用嵌套 Fork/Join 工作者任务的底层机制。定制的工作者可以消除使用通用工作者时参数扩散带来的性能开销。此外,自定义工作者可以在 Java 中实现,从而进一步提高算法的性能。

public final class FileCounter extends AbstractForkJoinWorker<Long> { private final File file;def FileCounter(final File file) { this.file = file }

@Override protected Long computeTask() { long count = 0; file.eachFile { if (it.isDirectory()) { println "Forking a thread for $it" forkOffChild(new FileCounter(it)) //fork a child task } else { count++ } } return count + ((childrenResults)?.sum() ?: 0) //use results of children tasks to calculate and store own result } }

withPool(1) {pool -> //feel free to experiment with the number of fork/join threads in the pool println "Number of files: ${runForkJoin(new FileCounter(new File("..")))}" }

AbstractForkJoinWorker 子类可以在 Java 或 Groovy 中编写,让您能够轻松优化执行速度,如果工作者的行性能成为瓶颈。

Fork/Join 节省您的资源

由于内部使用 TaskBarrier 类来同步线程,因此 Fork/Join 操作可以安全地用少量线程运行。当一个线程在算法内部被阻塞,等待其子问题被计算时,该线程会被静默地返回到池中,以承担任务队列中的任何可用子问题并处理它们。尽管该算法创建了与子目录一样多的任务,并且任务会等待子目录任务完成,但只需要一个线程就足以让计算继续进行,并最终计算出有效的结果。

归并排序示例

import static groovyx.gpars.GParsPool.runForkJoin import static groovyx.gpars.GParsPool.withPool/** * Splits a list of numbers in half */ def split(List<Integer> list) { int listSize = list.size() int middleIndex = listSize / 2 def list1 = list[0..<middleIndex] def list2 = list[middleIndex..listSize - 1] return [list1, list2] }

/** * Merges two sorted lists into one */ List<Integer> merge(List<Integer> a, List<Integer> b) { int i = 0, j = 0 final int newSize = a.size() + b.size() List<Integer> result = new ArrayList<Integer>(newSize)

while ((i < a.size()) && (j < b.size())) { if (a[i] <= b[j]) result << a[i++] else result << b[j++] }

if (i < a.size()) result.addAll(a[i..-1]) else result.addAll(b[j..-1]) return result }

final def numbers = [1, 5, 2, 4, 3, 8, 6, 7, 3, 4, 5, 2, 2, 9, 8, 7, 6, 7, 8, 1, 4, 1, 7, 5, 8, 2, 3, 9, 5, 7, 4, 3]

withPool(3) { //feel free to experiment with the number of fork/join threads in the pool println """Sorted numbers: ${ runForkJoin(numbers) {nums -> println "Thread ${Thread.currentThread().name[-1]}: Sorting $nums" switch (nums.size()) { case 0..1: return nums //store own result case 2: if (nums[0] <= nums[1]) return nums //store own result else return nums[-1..0] //store own result default: def splitList = split(nums) [splitList[0], splitList[1]].each {forkOffChild it} //fork a child task return merge(* childrenResults) //use results of children tasks to calculate and store own result } } }""" }

使用定制工作者类的归并排序示例

public final class SortWorker extends AbstractForkJoinWorker<List<Integer>> { private final List numbersdef SortWorker(final List<Integer> numbers) { this.numbers = numbers.asImmutable() }

/** * Splits a list of numbers in half */ def split(List<Integer> list) { int listSize = list.size() int middleIndex = listSize / 2 def list1 = list[0..<middleIndex] def list2 = list[middleIndex..listSize - 1] return [list1, list2] }

/** * Merges two sorted lists into one */ List<Integer> merge(List<Integer> a, List<Integer> b) { int i = 0, j = 0 final int newSize = a.size() + b.size() List<Integer> result = new ArrayList<Integer>(newSize)

while ((i < a.size()) && (j < b.size())) { if (a[i] <= b[j]) result << a[i++] else result << b[j++] }

if (i < a.size()) result.addAll(a[i..-1]) else result.addAll(b[j..-1]) return result }

/** * Sorts a small list or delegates to two children, if the list contains more than two elements. */ @Override protected List<Integer> computeTask() { println "Thread ${Thread.currentThread().name[-1]}: Sorting $numbers" switch (numbers.size()) { case 0..1: return numbers //store own result case 2: if (numbers[0] <= numbers[1]) return numbers //store own result else return numbers[-1..0] //store own result default: def splitList = split(numbers) [new SortWorker(splitList[0]), new SortWorker(splitList[1])].each{forkOffChild it} //fork a child task return merge(* childrenResults) //use results of children tasks to calculate and store own result } } }

final def numbers = [1, 5, 2, 4, 3, 8, 6, 7, 3, 4, 5, 2, 2, 9, 8, 7, 6, 7, 8, 1, 4, 1, 7, 5, 8, 2, 3, 9, 5, 7, 4, 3]

withPool(1) { //feel free to experiment with the number of fork/join threads in the pool println "Sorted numbers: ${runForkJoin(new SortWorker(numbers))}" }

直接运行子任务

forkOffChild() 方法有一个兄弟姐妹 - runChildDirectly() 方法,它将在当前线程中直接且立即运行子任务,而不是将子任务调度到线程池中进行异步处理。通常,您将在除最后一个子任务以外的所有子任务上调用 _forkOffChild(),最后一个子任务直接调用,没有调度开销。

Closure fib = {number ->

if (number <= 2) {

return 1

}

forkOffChild(number - 1) // This task will run asynchronously, probably in a different thread

final def result = runChildDirectly(number - 2) // This task is run directly within the current thread

return (Integer) getChildrenResults().sum() + result

} withPool {

assert 55 == runForkJoin(10, fib)

}

可用性

此功能仅在使用基于 Fork/Join 的GParsPool 时可用,在GParsExecutorsPool 中不可用。

3.7 并行推测

随着处理器内核变得越来越丰富,某些算法可能会从暴力并行复制中受益。您不必事先决定如何解决问题、使用什么算法或连接到哪个位置,而是并行运行所有可能的解决方案。并行推测

假设您需要执行一项任务,例如计算一个昂贵的函数或从文件、数据库或互联网读取数据。幸运的是,您知道几种好方法(例如函数或 URL)来实现您的目标。然而,它们并不完全相同。尽管它们返回相同的结果(就您的需求而言),但它们完成所需的时间可能各不相同,其中一些甚至可能失败(例如网络问题)。更糟糕的是,没有人会告诉你哪条路径最先给你解决方案,或者哪条路径根本没有解决方案。我应该在我的列表上运行 快速排序 还是 归并排序?哪个 URL 最好用?这项服务在其主位置可用,还是我应该使用备份位置?

GPars 推测为您提供了并行尝试所有可用备选方案的选项,从而从最快的功能路径获取结果,并静默地忽略缓慢或损坏的路径。

这就是 GParsPool 和 GParsExecutorsPool() 上的 speculate() 方法可以做到的。

def numbers = … def quickSort = … def mergeSort = … def sortedNumbers = speculate(quickSort, mergeSort)

在这里,我们同时执行 快速排序 和 归并排序 并发,同时获取速度更快的一个的结果。鉴于当今主流硬件上提供的并行资源,并行运行这两个函数不会对任一函数的计算速度产生重大影响,因此我们在大约与仅运行两个计算中速度更快的一个相同的时间内获得了结果。并且我们比运行速度较慢的一个更快地获得了结果。然而,我们不必事先知道两种排序算法中哪一种在我们的数据上表现更好。因此我们进行了推测。

同样,从多个速度和可靠性不同的源下载文档将如下所示

import static groovyx.gpars.GParsPool.speculate import static groovyx.gpars.GParsPool.withPooldef alternative1 = { 'http://www.dzone.com/links/index.html'.toURL().text }

def alternative2 = { 'http://www.dzone.com/'.toURL().text }

def alternative3 = { 'http://www.dzzzzzone.com/'.toURL().text //wrong url }

def alternative4 = { 'http://dzone.com/'.toURL().text }

withPool(4) { println speculate([alternative1, alternative2, alternative3, alternative4]).contains('groovy') }

确保周围的线程池有足够的线程来并行处理所有备选方案。池的大小应该与提供的闭包数量相匹配。

使用数据流变量和流的备选方案

在不需要停止不成功的备选方案的情况下,可以使用数据流变量或流从获胜的推测中获取结果值。

有关数据流变量和流的详细信息,请参阅用户指南中的数据流并发部分。

import groovyx.gpars.dataflow.DataflowQueue import static groovyx.gpars.dataflow.Dataflow.taskdef alternative1 = { 'http://www.dzone.com/links/index.html'.toURL().text }

def alternative2 = { 'http://www.dzone.com/'.toURL().text }

def alternative3 = { 'http://www.dzzzzzone.com/'.toURL().text //will fail due to wrong url }

def alternative4 = { 'http://dzone.com/'.toURL().text }

//Pick either one of the following, both will work: final def result = new DataflowQueue() // final def result = new DataflowVariable()

[alternative1, alternative2, alternative3, alternative4].each {code -> task { try { result << code() } catch (ignore) { } //We deliberately ignore unsuccessful urls } }

println result.val.contains('groovy')

4 Groovy CSP

CSP(通信顺序进程)抽象建立在独立的可组合进程之上,这些进程以同步的方式交换消息。GPars 利用了英国肯特大学开发的JCSP 库。GPars 中 CSP 实现的作者 Jon Kerridge 在他的网站上提供了关于 GroovyCSP 使用的详尽示例:

GroovyCSP 实现利用了 JCSP,一个基于 Java 的 CSP 库,该库在 LGPL 许可下授权。Apache 2 许可证(GPars 使用的许可证)与 LGPL 之间存在一些差异。请确保您的应用程序符合 LGPL 规则,然后再在您的代码中启用 JCSP 的使用。

如果 LGPL 许可证不适合您的使用,您可能需要考虑查看本用户指南的数据流并发章节,了解关于 任务、选择器 和 运算符 的知识,这些知识可能有助于您以类似于 CSP 方法的方式解决并发问题。事实上,GPars 中实现的数据流和 CSP 概念非常接近。

默认情况下,如果您没有在构建文件中显式添加对 JCSP 的依赖关系,或者没有下载并将 JCSP jar 文件包含在您的项目中,则您的项目将适用标准的商业软件友好型 Apache 2 许可证条款。GPars 仅直接依赖于在与 Apache 2 许可证兼容的许可证下授权的软件。

CSP 模型原则

从本质上讲,CSP 模型建立在独立的并发进程之上,这些进程通过使用同步(即会合)消息传递的通道相互通信。与围绕事件处理模式的 actor 或数据流运算符不同,CSP 进程专注于它们的活动(又名步骤序列),并使用通信在整个过程中保持相互同步。

由于寻址是通过通道间接进行的,因此进程不需要了解彼此。它们通常由一组输入和输出通道以及一个主体组成。一旦 CSP 进程启动,它就会从线程池中获取一个线程并开始处理它的主体,仅在从通道读取或写入通道时暂停。一些实现(例如 GoLang)还可以从 CSP 进程中分离线程,使其在通道阻塞时处于阻塞状态。

CSP 程序是确定性的。程序输入上的相同数据将始终生成相同的输出,而与实际使用的线程调度方案无关。这在调试 CSP 程序以及分析死锁时非常有帮助。

确定性和间接寻址相结合,使 CSP 进程具有高度的可组合性。您可以通过连接它们的输入和输出通道,然后将它们包装在另一个更大的包含进程中,将小的 CSP 进程组合成更大的进程。

CSP 模型使用 备选方案 引入非确定性。一个进程可以通过称为 备选方案 或 选择 的结构,尝试同时从多个通道读取值。在参与 选择 的任何通道中第一个可用的值将被进程读取和使用。由于通过 选择 收到的消息的顺序取决于程序运行时的不可预测条件,因此将读取的值是非确定性的。

GPars 数据流中的 CSP

GPars 提供了创建 CSP 进程所需的所有构建块。

- CSP 进程 可以通过 GPars 任务使用 闭包、Runnable 或 Callable 来建模,以保存进程的实际实现

- CSP 通道 应该使用 SyncDataflowQueue 和 SyncDataflowBroadcast 类来建模

- CSP 备选方案 通过 Select 类及其 select 和 prioritySelect 方法提供

进程

要启动一个进程,只需使用 task 工厂方法。

import groovyx.gpars.group.DefaultPGroup import groovyx.gpars.scheduler.ResizeablePoolgroup = new DefaultPGroup(new ResizeablePool(true))

def t = group.task { println "I am a process" }

t.join()

由于每个进程在其生命周期中都会消耗一个线程,因此建议使用可调整大小的线程池,如上面的示例所示。

也可以从 Runnable 或 Callable 对象创建进程

import groovyx.gpars.group.DefaultPGroup import groovyx.gpars.scheduler.ResizeablePoolgroup = new DefaultPGroup(new ResizeablePool(true))

class MyProcess implements Runnable {

@Override void run() { println "I am a process" } } def t = group.task new MyProcess()

t.join()

使用 Callable 允许通过 get() 方法返回值

import groovyx.gpars.group.DefaultPGroup import groovyx.gpars.scheduler.ResizeablePoolimport java.util.concurrent.Callable

group = new DefaultPGroup(new ResizeablePool(true))

class MyProcess implements Callable<String> {

@Override String call() { println "I am a process" return "CSP is great!" } } def t = group.task new MyProcess()

println t.get()

通道

进程通常需要通道来与其他进程以及外部世界通信

import groovy.transform.TupleConstructor import groovyx.gpars.dataflow.DataflowReadChannel import groovyx.gpars.dataflow.DataflowWriteChannel import groovyx.gpars.group.DefaultPGroup import groovyx.gpars.scheduler.ResizeablePoolimport java.util.concurrent.Callable import groovyx.gpars.dataflow.SyncDataflowQueue

group = new DefaultPGroup(new ResizeablePool(true))

@TupleConstructor class Greeter implements Callable<String> { DataflowReadChannel names DataflowWriteChannel greetings

@Override String call() { while(!Thread.currentThread().isInterrupted()) { String name = names.val greetings << "Hello " + name } return "CSP is great!" } }

def a = new SyncDataflowQueue() def b = new SyncDataflowQueue()

group.task new Greeter(a, b)

a << "Joe" a << "Dave" println b.val println b.val

CSP 模型使用同步消息传递,但是,在 GPars 中,您可以考虑使用异步通道以及同步通道。您也可以在一个进程中组合这两种类型的通道。

组合

对进程进行分组只是将它们与通道连接起来的问题

group = new DefaultPGroup(new ResizeablePool(true))@TupleConstructor class Formatter implements Callable<String> { DataflowReadChannel rawNames DataflowWriteChannel formattedNames

@Override String call() { while(!Thread.currentThread().isInterrupted()) { String name = rawNames.val formattedNames << name.toUpperCase() } } }

@TupleConstructor class Greeter implements Callable<String> { DataflowReadChannel names DataflowWriteChannel greetings

@Override String call() { while(!Thread.currentThread().isInterrupted()) { String name = names.val greetings << "Hello " + name } } }

def a = new SyncDataflowQueue() def b = new SyncDataflowQueue() def c = new SyncDataflowQueue()

group.task new Formatter(a, b) group.task new Greeter(b, c)

a << "Joe" a << "Dave" println c.val println c.val

备选方案

为了引入非确定性,GPars 提供了 Select 类及其 select 和 prioritySelect 方法

import groovy.transform.TupleConstructor import groovyx.gpars.dataflow.SyncDataflowQueue import groovyx.gpars.dataflow.DataflowReadChannel import groovyx.gpars.dataflow.DataflowWriteChannel import groovyx.gpars.dataflow.Select import groovyx.gpars.group.DefaultPGroup import groovyx.gpars.scheduler.ResizeablePoolimport static groovyx.gpars.dataflow.Dataflow.select

group = new DefaultPGroup(new ResizeablePool(true))

@TupleConstructor class Receptionist implements Runnable { DataflowReadChannel emails DataflowReadChannel phoneCalls DataflowReadChannel tweets DataflowWriteChannel forwardedMessages

private final Select incomingRequests = select([phoneCalls, emails, tweets]) //prioritySelect() would give highest precedence to phone calls

@Override void run() { while(!Thread.currentThread().isInterrupted()) { String msg = incomingRequests.select() forwardedMessages << msg.toUpperCase() } } }

def a = new SyncDataflowQueue() def b = new SyncDataflowQueue() def c = new SyncDataflowQueue() def d = new SyncDataflowQueue()

group.task new Receptionist(a, b, c, d)

a << "my email" b << "my phone call" c << "my tweet"

//The values come in random order since the process uses a Select to read its input 3.times{ println d.val.value }

组件

CSP 进程可以组合成更大的实体。假设您已经有一组 CSP 进程(又名 Runnable/Callable 类),您可以将它们组合成一个更大的进程

final class Prefix implements Callable { private final DataflowChannel inChannel private final DataflowChannel outChannel private final def prefixdef Prefix(final inChannel, final outChannel, final prefix) { this.inChannel = inChannel; this.outChannel = outChannel; this.prefix = prefix }

public def call() { outChannel << prefix while (true) { sleep 200 outChannel << inChannel.val } } }

final class Copy implements Callable { private final DataflowChannel inChannel private final DataflowChannel outChannel1 private final DataflowChannel outChannel2def Copy(final inChannel, final outChannel1, final outChannel2) { this.inChannel = inChannel; this.outChannel1 = outChannel1; this.outChannel2 = outChannel2; }

public def call() { final PGroup group = Dataflow.retrieveCurrentDFPGroup() while (true) { def i = inChannel.val group.task { outChannel1 << i outChannel2 << i }.join() } } }

import groovyx.gpars.dataflow.DataflowChannel import groovyx.gpars.dataflow.SyncDataflowQueue import groovyx.gpars.group.DefaultPGroupgroup = new DefaultPGroup(6)

def fib(DataflowChannel out) { group.task { def a = new SyncDataflowQueue() def b = new SyncDataflowQueue() def c = new SyncDataflowQueue() def d = new SyncDataflowQueue() [new Prefix(d, a, 0L), new Prefix(c, d, 1L), new Copy(a, b, out), new StatePairs(b, c)].each { group.task it} } }

final SyncDataflowQueue ch = new SyncDataflowQueue() group.task new Print('Fibonacci numbers', ch) fib(ch)

sleep 10000

5 Actor

GPars 中的 actor 支持最初受到 Scala 中的 Actors 库的启发,但现在已经远远超出了 Scala 作为标准提供的功能。Actor 允许基于消息传递的并发模型:程序是独立活动对象的集合,它们交换消息,并且没有可变的共享状态。Actor 可以帮助开发人员避免死锁、活锁和饥饿等问题,这些问题是基于共享内存的方法的常见问题。Actor 是一种利用当今硬件的多核性质而不会出现与共享内存多线程相关的所有传统问题的方法,这就是为什么 Erlang 和 Scala 等编程语言采用了这种模型。

Ruben Vermeersch 最近撰写了一篇总结 actor 关键概念 的好文章。Actor 始终保证最多只有一个线程处理 actor 的主体,并且在幕后也保证内存每次分配给 actor 时都会同步,因此 actor 的状态可以由主体中的代码安全地修改而无需任何其他额外(同步或锁定)工作。理想情况下,actor 的代码应该从外部直接调用,因此 actor 类的所有代码只能由处理最后接收的消息的线程执行,因此 actor 的所有代码都是隐式线程安全的。如果允许其他对象直接调用 actor 的任何方法,则 actor 的代码和状态的线程安全保证将不再有效。

Actor 类型

一般来说,您可以在野外找到两种类型的 actor - 具有隐式状态的 actor 和没有隐式状态的 actor。GPars 为您提供了这两种选择。无状态 actor,在GPars 中由 DynamicDispatchActor 和 ReactiveActor 类表示,不跟踪之前到达的消息。您可以将它们视为扁平的消息处理程序,它们会按顺序处理消息。任何基于状态的行为都必须由用户实现。

由 DefaultActor 类(以前也由 AbstractPooledActor 类)在 GPars 中表示的有状态 actor 允许用户直接处理隐式状态。在接收到消息后,actor 会进入一个新的状态,并以不同的方式处理未来的消息。举个例子,一个新启动的 actor 可能只接受某些类型的消息,例如,只有在它接收到加密密钥后才能接受用于解密的加密消息。有状态 actor 允许直接在消息处理代码的结构中编码这种依赖关系。但是,隐式状态管理会带来轻微的性能成本,这主要是由于 JVM 上缺乏对延续的支持。

Actor 线程模型

由于 actor 与系统线程分离,因此大量 actor 可以共享一个相对较小的线程池。这可以扩展到具有许多并发 actor 共享一个池化线程的情况。这种架构可以避免 JVM 的一些线程限制。一般来说,虽然 JVM 只能为您提供有限数量的线程(通常约为几千个),但 actor 的数量仅受可用内存的限制。如果 actor 没有工作要做,它就不会消耗线程。

actor 代码在等待新事件(消息)的静默期间由块处理。这可以通过 延续 自然地建模。由于 JVM 不直接支持延续,因此必须在 actor 框架中模拟它们,这对 actor 代码的组织有一定的影响。但是,在大多数情况下,好处大于困难。

import groovyx.gpars.actor.Actor import groovyx.gpars.actor.DefaultActorclass GameMaster extends DefaultActor { int secretNum

void afterStart() { secretNum = new Random().nextInt(10) }

void act() { loop { react { int num -> if (num > secretNum) reply 'too large' else if (num < secretNum) reply 'too small' else { reply 'you win' terminate() } } } } }

class Player extends DefaultActor { String name Actor server int myNum

void act() { loop { myNum = new Random().nextInt(10) server.send myNum react { switch (it) { case 'too large': println "$name: $myNum was too large"; break case 'too small': println "$name: $myNum was too small"; break case 'you win': println "$name: I won $myNum"; terminate(); break } } } } }

def master = new GameMaster().start() def player = new Player(name: 'Player', server: master).start()

//this forces main thread to live until both actors stop [master, player]*.join()

Actor 的使用

Gpars 提供一致的 Actor API 和 DSL。Actor 主要执行三个特定操作 - 发送消息、接收消息和创建新 actor。虽然没有被GPars 特别强制执行,但消息应该是不可变的,或者至少在发送者在消息发送后不再触碰消息时遵循 hands-off 策略。

发送消息

可以使用 send() 方法将消息发送给 actor。

def passiveActor = Actors.actor{

loop {

react { msg -> println "Received: $msg"; }

}

}

passiveActor.send 'Message 1'

passiveActor << 'Message 2' //using the << operator

passiveActor 'Message 3' //using the implicit call() method或者,可以使用 << 运算符或隐式 call() 方法。可以使用 sendAndWait() 方法系列来阻塞调用方,直到收到 actor 的回复。 reply 将作为返回值从 sendAndWait() 方法返回。 sendAndWait() 方法也可以在超时到期或被调用 actor 终止时返回。

def replyingActor = Actors.actor{

loop {

react { msg ->

println "Received: $msg";

reply "I've got $msg"

}

}

}

def reply1 = replyingActor.sendAndWait('Message 4')

def reply2 = replyingActor.sendAndWait('Message 5', 10, TimeUnit.SECONDS)

use (TimeCategory) {

def reply3 = replyingActor.sendAndWait('Message 6', 10.seconds)

}sendAndContinue() 方法允许调用方在提供的闭包等待 actor 的回复时继续其处理。

friend.sendAndContinue 'I need money!', {money -> pocket money}

println 'I can continue while my friend is collecting money for me'sendAndPromise() 方法返回对最终回复的 Promise(又名 Future),因此允许调用方在 actor 处理提交的消息时继续其处理。

Promise loan = friend.sendAndPromise 'I need money!' println 'I can continue while my friend is collecting money for me' loan.whenBound {money -> pocket money} //asynchronous waiting for a reply println "Received ${loan.get()}" //synchronous waiting for a reply

所有 send()、sendAndWait() 或 sendAndContinue() 方法如果在非活动 actor 上调用,都会抛出异常。

接收消息

非阻塞消息检索

在 actor 的代码中调用 react() 方法(可选地使用超时参数)将从 actor 的收件箱中使用下一条消息,如果立即没有消息要处理,可能会等待。

println 'Waiting for a gift' react {gift -> if (myWife.likes gift) reply 'Thank you!' }

在幕后,提供的闭包不会直接被调用,而是被安排在消息可用时由线程池中的任何线程处理。安排后,当前线程将从 actor 中分离,并释放以处理已收到消息的任何其他 actor。

为了允许从线程中分离 actor, react() 方法要求代码以特殊的延续风格编写。

Actors.actor {

loop {

println 'Waiting for a gift'

react {gift ->

if (myWife.likes gift) reply 'Thank you!'

else {

reply 'Try again, please'

react {anotherGift ->

if (myChildren.like gift) reply 'Thank you!'

}

println 'Never reached'

}

}

println 'Never reached'

}

println 'Never reached'

}react() 方法具有特殊的语义,允许 actor 在其邮箱中没有消息可用时从线程中分离。本质上, react() 安排提供的代码(闭包)在下一条消息到达时执行并返回。提供给 react() 方法的闭包是计算应该继续的代码。因此,延续风格。

由于 Actor 必须保证其主体中最多只有一个线程处于活动状态,因此在当前消息处理完成之前无法处理下一个消息。通常情况下,不需要在调用 react() 之后放置代码。某些 Actor 实现甚至强制执行此规则,但 GPars 出于性能原因不执行此规则。 loop() 方法允许在 Actor 主体中进行迭代。与典型的循环结构(如 for 或 while 循环)不同,loop() 与嵌套的 react() 块协作,并确保跨后续消息检索进行循环。

发送回复

除了 Actor 本身,reply/replyIfExists 方法也定义在 AbstractPooledActor 上(在 DefaultActor、DynamicDispatchActor 或 ReactiveActor 类中不可用),当接收消息时,它也定义在处理过的消息本身之上,这在一次调用中处理多个消息时非常有用。在这种情况下,在 Actor 上调用的 reply() 会向所有当前正在处理的消息(最后一个消息)的作者发送回复,而调用消息上的 reply() 只会向特定消息的作者发送回复。

发送者属性

检索到的消息提供发送者属性来标识消息的发送者。该属性在 Actor 的闭包内可用

react {tweet ->

if (isSpam(tweet)) ignoreTweetsFrom sender

sender.send 'Never write me again!'

}转发

发送消息时,可以指定不同的 Actor 作为发送者,以便潜在的回复将转发到指定的 Actor,而不是实际的发送者。

def decryptor = Actors.actor {

react {message ->

reply message.reverse()

// sender.send message.reverse() //An alternative way to send replies

}

}def console = Actors.actor { //This actor will print out decrypted messages, since the replies are forwarded to it

react {

println 'Decrypted message: ' + it

}

}

decryptor.send 'lellarap si yvoorG', console //Specify an actor to send replies to

console.join()

创建 Actor

Actor 共享一个 线程池,当 Actor 需要对发送给它们的 消息 作出反应 时,这些线程会动态分配给 Actor。当消息处理完毕,并且 Actor 处于空闲状态等待更多消息到达时,这些线程会返回到线程池。

例如,以下是如何创建打印接收到的所有消息的 Actor。

def console = Actors.actor {

loop {

react {

println it

}

}

}注意 loop() 方法调用,它确保 Actor 在处理完第一条消息后不会停止。

这是一个解密服务的示例,它可以解密提交的消息,并将解密后的消息发送回发送者。

final def decryptor = Actors.actor { loop { react {String message -> if ('stopService' == message) { println 'Stopping decryptor' stop() } else reply message.reverse() } } }Actors.actor { decryptor.send 'lellarap si yvoorG' react { println 'Decrypted message: ' + it decryptor.send 'stopService' } }.join()

以下是一个 Actor 的示例,它等待最多 30 秒以接收其消息的回复。

def friend = Actors.actor {

react {

//this doesn't reply -> caller won't receive any answer in time

println it

//reply 'Hello' //uncomment this to answer conversation

react {

println it

}

}

}def me = Actors.actor {

friend.send('Hi')

//wait for answer 1sec

react(1000) {msg ->

if (msg == Actor.TIMEOUT) {

friend.send('I see, busy as usual. Never mind.')

stop()

} else {

//continue conversation

println "Thank you for $msg"

}

}

}

me.join()

未送达的消息

有时消息无法传递到目标 Actor。当需要对未送达的消息采取特殊操作时,在 Actor 终止时,其队列中所有未处理的消息都会调用其 onDeliveryError() 方法。 onDeliveryError() 方法或定义在消息上的闭包可以,例如,将通知发送回消息的原始发送者。

final DefaultActor me me = Actors.actor { def message = 1message.metaClass.onDeliveryError = {-> //send message back to the caller me << "Could not deliver $delegate" }

def actor = Actors.actor { react { //wait 2sec in order next call in demo can be emitted Thread.sleep(2000) //stop actor after first message stop() } }

actor << message actor << message

react { //print whatever comes back println it }

}

me.join()

或者,可以指定发送者本身的 onDeliveryError() 方法。该方法既可以动态添加

final DefaultActor me me = Actors.actor { def message1 = 1 def message2 = 2def actor = Actors.actor { react { //wait 2sec in order next call in demo can be emitted Thread.sleep(2000) //stop actor after first message stop() } }

me.metaClass.onDeliveryError = {msg -> //callback on actor inaccessibility println "Could not deliver message $msg" }

actor << message1 actor << message2

actor.join()

}

me.join()

也可以在 Actor 定义中静态添加

class MyActor extends DefaultActor { public void onDeliveryError(msg) { println "Could not deliver message $msg" } … }

加入 Actor

Actor 提供 join() 方法,允许调用者等待 Actor 终止。还提供了一个接受超时的变体。当同时加入多个 Actor 时,Groovy 的 spread-dot 运算符非常有用。

def master = new GameMaster().start() def player = new Player(name: 'Player', server: master).start()[master, player]*.join()

条件和计数循环

loop() 方法允许指定条件或迭代次数,可以选择性地附加一个闭包以在循环结束后调用 - 循环结束后的代码处理器 。

以下 Actor 将循环三次以接收 3 条消息,然后打印接收到的消息的最大值。

final Actor actor = Actors.actor { def candidates = [] def printResult = {-> println "The best offer is ${candidates.max()}"}loop(3, printResult) { react { candidates << it } } }

actor 10 actor 30 actor 20 actor.join()

以下 Actor 将接收消息,直到收到大于 30 的值。

final Actor actor = Actors.actor { def candidates = [] final Closure printResult = {-> println "Reached best offer - ${candidates.max()}"}loop({-> candidates.max() < 30}, printResult) { react { candidates << it } } }

actor 10 actor 20 actor 25 actor 31 actor 20 actor.join()

循环结束后的代码处理器 可以使用 Actor 的 react{} 但不能使用 loop() 。

DefaultActor 可以设置为以公平或非公平(默认)的方式运行。根据选择的策略,Actor 要么使线程对共享相同并行组的其他 Actor 可用(公平),要么将线程保留给自己,直到消息队列为空(非公平)。一般来说,非公平 Actor 的性能比公平 Actor 好 2 到 3 倍。使用 fairActor() 工厂方法或 Actor 的 makeFair() 方法。

自定义调度器

Actor 默认情况下利用标准 JDK 并发库。要提供自定义线程调度器,请在创建并行组(PGroup 类)时使用相应的构造函数参数。提供的调度器将在组的线程池中协调线程。

请参阅众多 Actor 演示 。

5.1 Actor 原则

Actor 共享一个 线程池,当 Actor 需要对发送给它们的 消息 作出反应 时,这些线程会动态分配给 Actor。当消息处理完毕,并且 Actor 处于空闲状态等待更多消息到达时,这些线程会返回到线程池。Actor 从底层线程中分离出来,因此相对较小的线程池可以为潜在的无限数量的 Actor 提供服务。Actor 数量的虚拟无限可扩展性是 基于事件的 Actor 的主要优势,它们与底层物理线程分离。以下是一些使用 Actor 的示例。以下是如何创建打印接收到的所有消息的 Actor。

import static groovyx.gpars.actor.Actors.actordef console = actor { loop { react { println it } }

注意 loop() 方法调用,它确保 Actor 在处理完第一条消息后不会停止。

或者,您可以扩展 DefaultActor 类并重写 act() 方法。实例化 Actor 后,您需要启动它,以便它附加到线程池并开始接受消息。 actor() 工厂方法将负责启动 Actor。

class CustomActor extends DefaultActor { @Override protected void act() { loop { react { println it } } } }def console=new CustomActor() console.start()

可以使用多种方法向 Actor 发送消息

console.send('Message')

console 'Message'

console.sendAndWait 'Message' //Wait for a reply

console.sendAndContinue 'Message', {reply -> println "I received reply: $reply"} //Forward the reply to a function创建异步服务

import static groovyx.gpars.actor.Actors.actorfinal def decryptor = actor { loop { react {String message-> reply message.reverse() } } }

def console = actor { decryptor.send 'lellarap si yvoorG' react { println 'Decrypted message: ' + it } }

console.join()

如您所见,您可以使用 actor() 方法创建新的 Actor,将 Actor 主体作为闭包参数传递。在 Actor 主体中,您可以使用 loop() 进行迭代,使用 react() 接收消息,使用 reply() 向发送当前处理消息的 Actor 发送消息。当前消息的发送者也可以通过 Actor 的 sender 属性获得。当解密 Actor 在调用 react() 时,其消息队列中没有消息时,react() 方法会放弃线程并将其返回到线程池供其他 Actor 拾取。只有在 Actor 的消息队列中收到新消息后,才会将 react() 方法的闭包安排在池中进行处理。基于事件的 Actor 在内部模拟了延续 - Actor 的工作被分割成按顺序运行的块,这些块在消息在收件箱中可用时被调用。单个 Actor 的每个块都可以由线程池中的不同线程执行。

Groovy 灵活的语法与闭包相结合,使我们的库能够提供多种定义 Actor 的方式。例如,以下是一个 Actor 的示例,它等待最多 30 秒以接收其消息的回复。Actor 允许由 org.codehaus.groovy.runtime.TimeCategory 类定义的时间 DSL 用于对 react() 方法指定超时,前提是用户将调用包含在 TimeCategory 使用块中。

def friend = Actors.actor {

react {

//this doesn't reply -> caller won't receive any answer in time

println it

//reply 'Hello' //uncomment this to answer conversation

react {

println it

}

}

}def me = Actors.actor {

friend.send('Hi')

//wait for answer 1sec

react(1000) {msg ->

if (msg == Actor.TIMEOUT) {

friend.send('I see, busy as usual. Never mind.')

stop()

} else {

//continue conversation

println "Thank you for $msg"

}

}

}

me.join()

当等待消息时超时到期时,将收到 Actor.TIMEOUT 消息。如果存在,还会调用 onTimeout() 处理程序

def friend = Actors.actor {

react {

//this doesn't reply -> caller won't receive any answer in time

println it

//reply 'Hello' //uncomment this to answer conversation

react {

println it

}

}

}def me = Actors.actor {

friend.send('Hi')

delegate.metaClass.onTimeout = {->

friend.send('I see, busy as usual. Never mind.')

stop()

}

//wait for answer 1sec

react(1000) {msg ->

if (msg != Actor.TIMEOUT) {

//continue conversation

println "Thank you for $msg"

}

}

}

me.join()

注意可以使用 Groovy 元编程来动态定义 Actor 的生命周期通知方法(例如 onTimeout() )。当然,当您决定为您的 Actor 定义一个新类时,可以以通常的方式定义生命周期方法。

class MyActor extends DefaultActor { public void onTimeout() { … }protected void act() { … } }

Actor 保证非线程安全代码的线程安全

Actor 保证始终最多有一个线程一次处理 Actor 的主体,并且在幕后,每次线程被分配给 Actor 时都会同步内存,因此 Actor 的状态 可以安全地修改,代码在主体中 无需任何其他额外(同步或锁定)工作 。

class MyCounterActor extends DefaultActor { private Integer counter = 0protected void act() { loop { react { counter++ } } } }

理想情况下,Actor 的代码 绝不应该 从外部直接调用,因此 Actor 类中的所有代码都只能由处理最后一个接收到的消息的线程执行,因此所有 Actor 的代码都是 隐式线程安全 的。如果允许其他对象直接调用 Actor 的任何方法,则 Actor 代码和状态的线程安全保证 不再有效 。

简单的计算器

这是一个更现实的基于事件的 Actor 示例,它接收两个数字消息,将它们加起来,并将结果发送到控制台 Actor。

import groovyx.gpars.group.DefaultPGroup//not necessary, just showing that a single-threaded pool can still handle multiple actors def group = new DefaultPGroup(1);

final def console = group.actor { loop { react { println 'Result: ' + it } } }

final def calculator = group.actor { react {a -> react {b -> console.send(a + b) } } }

calculator.send 2 calculator.send 3

calculator.join() group.shutdown()

请注意,基于事件的 Actor 需要特别注意 react() 方法。由于 基于事件的 Actor 需要将代码分割成可以按顺序分配给不同线程的独立块,并且 JVM 本身不支持 延续 ,因此这些块是人工创建的。 react() 方法创建下一个消息处理程序。一旦当前消息处理程序完成,下一个消息处理程序(延续)就会被调度。

并发归并排序示例

为了进行比较,我还包含了一个更复杂的示例,它使用 Actor 对整数列表进行并发归并排序。您可以看到,由于 Groovy 的灵活性,我们非常接近 Scala 模型,尽管我仍然错过了 Scala 模式匹配用于消息处理。

import groovyx.gpars.group.DefaultPGroup import static groovyx.gpars.actor.Actors.actorClosure createMessageHandler(def parentActor) { return { react {List<Integer> message -> assert message != null switch (message.size()) { case 0..1: parentActor.send(message) break case 2: if (message[0] <= message[1]) parentActor.send(message) else parentActor.send(message[-1..0]) break default: def splitList = split(message)

def child1 = actor(createMessageHandler(delegate)) def child2 = actor(createMessageHandler(delegate)) child1.send(splitList[0]) child2.send(splitList[1])

react {message1 -> react {message2 -> parentActor.send merge(message1, message2) } } } } } }

def console = new DefaultPGroup(1).actor { react { println "Sorted array:t${it}" System.exit 0 } }

def sorter = actor(createMessageHandler(console)) sorter.send([1, 5, 2, 4, 3, 8, 6, 7, 3, 9, 5, 3]) console.join()

def split(List<Integer> list) { int listSize = list.size() int middleIndex = listSize / 2 def list1 = list[0..<middleIndex] def list2 = list[middleIndex..listSize - 1] return [list1, list2] }

List<Integer> merge(List<Integer> a, List<Integer> b) { int i = 0, j = 0 final int newSize = a.size() + b.size() List<Integer> result = new ArrayList<Integer>(newSize)

while ((i < a.size()) && (j < b.size())) { if (a[i] <= b[j]) result << a[i++] else result << b[j++] }

if (i < a.size()) result.addAll(a[i..-1]) else result.addAll(b[j..-1]) return result }

由于 Actor 从池中重用线程,因此脚本将使用几乎 任何大小的线程池 工作,无论沿途创建了多少 Actor。

Actor 生命周期方法

每个 Actor 都可以定义生命周期观察方法,这些方法将在每次发生特定生命周期事件时调用。- afterStart() - 在 Actor 启动后立即调用。

- afterStop(List undeliveredMessages) - 在 Actor 停止后立即调用,传入队列中所有未处理的消息。

- onInterrupt(InterruptedException e) - 当 Actor 的线程被中断时调用。线程中断将导致 Actor 在任何情况下停止。

- onTimeout() - 当在为当前阻塞的 react 方法指定的超时时间内没有消息发送到 Actor 时调用。

- onException(Throwable e) - 当 Actor 的事件处理程序中发生异常时调用。Actor 将在此方法返回后停止。

您可以在您的 Actor 类中静态定义这些方法,也可以动态地将它们添加到 Actor 的元类中

class MyActor extends DefaultActor { public void afterStart() { … } public void onTimeout() { … }protected void act() { … } }

def myActor = actor {

delegate.metaClass.onException = {

log.error('Exception occurred', it)

}…

}

为了提高性能,您可以考虑使用 silentStart() 方法而不是 start() 来启动 DynamicDispatchActor 或 ReactiveActor 。调用 silentStart() 将绕过部分启动机制,因此也将避免调用 afterStart() 方法。由于其有状态的性质,DefaultActor 无法以静默方式启动。

池管理

Actor 可以被组织成组,默认情况下,始终有一个应用程序范围的池化 actor 组可用。就像使用 Actor 抽象工厂可以在默认组中创建 actor 一样,自定义组可以作为抽象工厂来创建属于这些组的新 actor 实例。

def myGroup = new DefaultPGroup()def actor1 = myGroup.actor { … }

def actor2 = myGroup.actor { … }

actor 的 parallelGroup 属性指向它所属的组。默认情况下,它指向默认 actor 组,即 Actors.defaultActorPGroup,并且只能在 actor 启动之前更改。

class MyActor extends StaticDispatchActor<Integer> { private static PGroup group = new DefaultPGroup(100)MyActor(...) { this.parallelGroup = group … } }

属于同一组的 actor 共享该组的 底层线程池。默认情况下,池包含 n + 1 个线程,其中 n 代表 JVM 检测到的 CPU 数量。可以通过设置 gpars.poolsize 系统属性或为每个 actor 组分别指定适当的构造函数参数,来 显式 设置 池大小。

def myGroup = new DefaultPGroup(10) //the pool will contain 10 threads可以通过适当的 DefaultPGroup 类操作线程池,该类 委托 给线程池的 Pool 接口。例如,resize() 方法允许您随时更改池大小,而 resetDefaultSize() 方法将其恢复为默认值。当您需要安全地完成所有任务、销毁池并停止所有线程以便以组织的方式退出 JVM 时,可以调用 shutdown() 方法。

… (n+1 threads in the default pool after startup)Actors.defaultActorPGroup.resize 1 //use one-thread pool

… (1 thread in the pool)

Actors.defaultActorPGroup.resetDefaultSize()

… (n+1 threads in the pool)

Actors.defaultActorPGroup.shutdown()

作为 DefaultPGroup 的替代方案,DefaultPGroup 创建了一个守护线程池,当需要非守护线程时,可以使用 NonDaemonPGroup 类。

def daemonGroup = new DefaultPGroup()def actor1 = daemonGroup.actor { … }

def nonDaemonGroup = new NonDaemonPGroup()

def actor2 = nonDaemonGroup.actor { … }

class MyActor { def MyActor() { this.parallelGroup = nonDaemonGroup }

void act() {...} }

属于同一组的 actor 共享 底层线程池。使用池化 actor 组,您可以将 actor 分割以利用多个不同大小的线程池,从而将资源分配给系统的不同组件并调整其性能。

def coreActors = new NonDaemonPGroup(5) //5 non-daemon threads pool def helperActors = new DefaultPGroup(1) //1 daemon thread pooldef priceCalculator = coreActors.actor { … }

def paymentProcessor = coreActors.actor { … }

def emailNotifier = helperActors.actor { … }

def cleanupActor = helperActors.actor { … }

//increase size of the core actor group coreActors.resize 6

//shutdown the group's pool once you no longer need the group to release resources helperActors.shutdown()

不要忘记在不再需要它们及其 actor 时关闭自定义池化 actor 组,以保留系统资源。

默认 actor 组

没有更改其 parallelGroup 属性或通过 Actors 类上的任何工厂方法创建的 actor 共享一个公共组 Actors.defaultActorPGroup。该组使用 可调整大小的线程池,其上限为 1000 个线程。这使您能够安心地让池自动根据 actor 的需求进行调整。另一方面,随着 actor 数量的增加,池可能会变得过大而效率低下。建议将 actor 分组到您自己的 PGroup 中,使用固定大小的线程池,除了最简单的应用程序之外,其他所有应用程序都应如此。

常见陷阱:应用程序终止,而 actor 未收到消息

您最有可能使用的是守护线程和池,这是默认设置,并且您的主线程已完成。在您任何、部分或所有 actor 上调用 actor.join() 将阻塞主线程,直到 actor 终止,从而保持所有 actor 运行。或者,使用 NonDaemonPGroup 的实例,并将一些 actor 分配给这些组。

def nonDaemonGroup = new NonDaemonPGroup()

def myActor = nonDaemonGroup.actor {...}或者

def nonDaemonGroup = new NonDaemonPGroup()class MyActor extends DefaultActor { def MyActor() { this.parallelGroup = nonDaemonGroup }

void act() {...} }

def myActor = new MyActor()

阻塞 Actor

在某些情况下,您可能更喜欢使用阻塞 actor,而不是使用事件驱动的 continuation 风格的 actor。阻塞 actor 为其整个生命周期(包括等待消息的时间)保留一个单一的池化线程。它们避免了一些线程管理开销,因为它们在启动后不会争夺线程,而且它们让您能够编写直观的代码,而无需使用 continuation 风格,因为它们只通过 receive 方法执行阻塞消息读取。显然,同时运行的阻塞 actor 数量受共享池中可用线程数量的限制。另一方面,阻塞 actor 通常比 continuation 风格的 actor 具有更好的性能,尤其是在 actor 的消息队列很少为空的情况下。

def decryptor = blockingActor {

while (true) {

receive {message ->

if (message instanceof String) reply message.reverse()

else stop()

}

}

}def console = blockingActor {

decryptor.send 'lellarap si yvoorG'

println 'Decrypted message: ' + receive()

decryptor.send false

}

[decryptor, console]*.join()

阻塞 actor 增加了调整应用程序性能的选项数量。它们可能是 actor 网络中高流量位置的理想选择。

5.2 无状态 Actor

动态分派 Actor